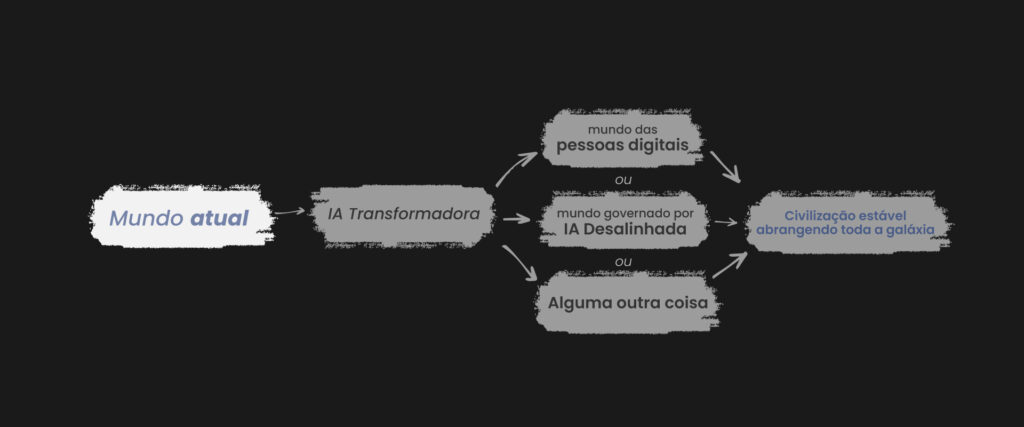

Anteriormente na série “o século mais importante”, argumentei haver uma alta probabilidade116 de que as próximas décadas verão:

- O desenvolvimento de uma tecnologia como o PASTA (processo para automação do avanço científico e tecnológico).

- Uma resultante explosão de produtividade, levando ao desenvolvimento de novas tecnologias transformadoras.

- Os primórdios de uma civilização estável em toda a galáxia, possivelmente povoada por pessoas digitais, ou gerida por uma Inteligência Artificial desalinhada.

Essa é uma visão otimista ou pessimista do mundo? Para mim, são as duas coisas e nenhuma, porque esse conjunto de eventos pode acabar sendo muito bom ou muito ruim para o mundo, dependendo de como ele se desenrolar.

Quando falo em estar no “século mais importante”, não quero dizer apenas que eventos importantes irão ocorrer. Quero dizer que nós, as pessoas que vivem neste século, temos a oportunidade de causar um enorme impacto no grande número de pessoas que existirão no futuro — se conseguirmos compreender essa situação o suficiente para tomar medidas que sejam úteis.

Mas, também, é importante entender por que esse é um grande “se” – porque o século mais importante apresenta um cenário estratégico desafiador, de tal forma que muitas coisas que fizermos podem melhorar ou piorar as coisas (e é difícil dizer quais seriam elas).

Nesta postagem, apresentarei dois cenários contrastantes de como aproveitar melhor o século mais importante:

- O modelo “Cautela”. Nesse modelo, muitos dos piores resultados decorrem do desenvolvimento de algo como o PASTA de uma maneira muito rápida, apressada ou imprudente. Podemos precisar alcançar uma coordenação (possivelmente global) para mitigar as pressões para competir e tomar os devidos cuidados. (Atenção)

- O modelo “Competição”. Esse modelo não se concentra em como e quando o PASTA será desenvolvido, mas quem (quais governos, quais empresas, etc.) será o primeiro a se beneficiar da explosão de produtividade resultante. (Competição)

- As pessoas que seguem o modelo de “cautela” e as pessoas que adotam o modelo de “competição”, favorecem geralmente medidas muito diferentes e até contraditórias. Medidas que parecem importantes para as pessoas em um modelo, muitas vezes são ativamente prejudiciais para as pessoas no outro.

O Eu me preocupo com o fato do modelo de “competição” ser superestimado por padrão e discuto o porquê abaixo. (Mais)

- Para entender melhor como avaliar esses modelos e quais ações provavelmente serão úteis, precisamos de mais progresso nas perguntas em aberto sobre o tamanho dos diferentes tipos de riscos da Inteligência Artificial transformadora. (Perguntas abertas)

- Nesse ínterim, existem algumas ações vigorosamente úteis que podem provavelmente melhorar as perspectivas da humanidade de alguma maneira. (Ações vigorosamente úteis)

O modelo “cautela”.

Defendi a probabilidade de que este século terá uma transição para um mundo onde pessoas digitais ou Inteligência Artificial desalinhada (ou algo muito diferente dos humanos de hoje) serão a principal força nos eventos mundiais.

O modelo de “cautela” enfatiza que alguns tipos de transição podem ser melhores do que outras. Abaixo, elas estão listadas em ordem da pior para a melhor:

A pior: Inteligência Artificial desalinhada

Eu discuti essa possibilidade anteriormente, baseando-me em uma série de outras discussões mais completas.117 A ideia básica é que os sistemas de Inteligência Artificial podem acabar desenvolvendo objetivos próprios e procurar ganhar espaço cumprindo esses objetivos. Os seres humanos, e/ou todos os valores humanos, podem ser ignorados (ou extintos, se de outra forma os atrapalharmos).

A segunda pior:118 Maturidade Tecnológica Adversária

Se chegarmos ao ponto em que existem pessoas digitais e/ou IAs (não desalinhadas) que podem se copiar sem limites e se expandir pelo espaço, pode haver uma pressão intensa para os atores agirem — e se multiplicarem (via cópia) — o mais rápido possível, a fim de ganhar mais influência sobre o mundo. Isso pode levar diferentes países/coalizões a furiosamente tentarem ultrapassar uns aos outros e/ou a um conflito militar total, sabendo que muito pode estar em jogo em pouco tempo.

Suponho que esse tipo de dinâmica teria o risco de deixar grande parte da galáxia em mau estado.119

Um desses cenários ruins seria estar “permanentemente sob o controle de uma única pessoa (digital) (e/ou suas cópias)”. Devido ao potencial das pessoas digitais para criar civilizações estáveis, um determinado regime totalitário poderia acabar permanentemente entrincheirado em partes substanciais da galáxia.

Pessoas/países/coalizões que suspeitam uns dos outros de representar esse tipo de perigo – de potencialmente estabelecer civilizações estáveis sob seu controle – competiriam e/ou atacariam uns aos outros desde o início para evitar que isso acontecesse. Isso poderia acarretar uma guerra com resultados difíceis de prever (devido aos avanços tecnológicos difíceis de prever que o PASTA poderia trazer).

A segunda melhor: negociação e governança

Os países evitariam esse tipo de dinâmica de Maturidade Tecnológica Adversária planejando e negociando entre si. Por exemplo, talvez cada país, ou cada pessoa, tivesse permissão para criar um certo número de pessoas digitais (sujeito a proteções de direitos humanos e outros regulamentos), limitado a uma determinada região do espaço.

Há uma enorme variedade de diferentes potenciais específicos aqui, alguns muito melhores e mais justos do que outros.

A melhor: reflexão

O mundo atingiria um nível de coordenação alto o suficiente para atrasar quaisquer etapas irreversíveis do processo de transição (incluindo o início de uma dinâmica de Maturidade Tecnológica Adversária).

Haveria, então, algo como o que Toby Ord (em O precipício) chama de “Longa Reflexão”:120 um longo período no qual as pessoas decidiriam coletivamente sobre metas e esperanças para o futuro, que representassem idealmente o compromisso mais justo disponível entre diferentes perspectivas. A tecnologia avançada ajudaria esse processo a ser muito melhor do que seria possível atualmente.121

Há perguntas ilimitadas sobre como tal “reflexão” funcionaria e se há realmente alguma esperança de que chegaríamos a um resultado razoavelmente bom e justo. Detalhes como “que tipos de pessoas digitais seriam criadas primeiro” seriam extremamente importantes. Atualmente, há pouca discussão sobre esse tipo de tópico.122

Outra

Provavelmente existem muitos tipos possíveis de transições que não mencionei aqui.

O papel da cautela

Se a ordem acima estiver correta, então o futuro da galáxia seria melhor se:

- A Inteligência Artificial desalinhada fosse evitada: sistemas de Inteligência Artificial poderosos agiriam para ajudar os humanos, em vez de buscar seus próprios objetivos.

- A Maturidade Tecnológica Adversária fosse evitada. Isso provavelmente significaria que as pessoas não implantariam sistemas avançados de IA, ou suas tecnologias resultantes, de maneira adversária (a menos que isso fosse necessário para evitar algo pior).

- Uma coordenação suficiente fosse alcançada para os principais atores conseguirem desacelerar, tornando a Reflexão uma possibilidade.

Idealmente, todos com potencial para construir algo semelhante ao PASTA conseguiriam focar sua energia na construção de algo seguro (não desalinhado) e planejariam cuidadosamente (e negociariam com os outros) como implementá-lo, sem pressa ou competição. Com isso em mente, talvez devêssemos fazer coisas como:

- Trabalhar para melhorar a confiança e a cooperação entre as principais potências mundiais. Talvez, por meio de versões da Pugwash centradas em Inteligência Artificial (uma conferência internacional visando reduzir o risco de conflito militar), ou recuar de movimentos de relações exteriores mais agressivos.

- Desencorajar governos e investidores a investir dinheiro em pesquisas de IA, encorajar os laboratórios de Inteligência Artificial a considerar minuciosamente as implicações de suas pesquisas antes de publicá-las ou ampliá-las, etc. Desacelerar as coisas dessa maneira seria uma forma de ganhar mais tempo para pesquisar sobre como evitar a Inteligência Artificial desalinhada, mais tempo para construir mecanismos de confiança e cooperação, mais tempo para obter clareza estratégica geral e uma menor probabilidade da dinâmica de Maturidade Tecnológica Adversária.

O modelo “competição”

(Observação: há algum potencial para confusão entre a ideia de “competição” e a ideia de Maturidade Tecnológica Adversária, então tentei empregar termos muito diferentes. Explico esse contraste em uma nota de rodapé.123)

O modelo de “competição” se concentra menos em como a transição para um futuro radicalmente diferente aconteceria e mais em quem estaria tomando as decisões principais quando a transição acontecesse.

- Se algo como o PASTA fosse desenvolvido principalmente (ou primeiro) no país X, então o governo do país X tomaria muitas decisões cruciais sobre se, e como, regular uma potencial explosão de novas tecnologias.

- Além disso, as pessoas e organizações que liderassem o desenvolvimento da Inteligência Artificial e outros avanços tecnológicos nessa época, seriam especialmente influentes em tais decisões.

Isso significa que “quem liderasse o desenvolvimento da Inteligência Artificial transformadora” seria muito importante – o país ou países, pessoas ou organizações.

- Os governos que liderassem a Inteligência Artificial transformadora seriam regimes autoritários?

- Quais governos teriam maior probabilidade de (efetivamente) compreender razoavelmente os riscos e consequências ao tomar decisões importantes?

- Quais governos seriam menos propensos a usar tecnologia avançada para consolidar o poder e o domínio de um grupo? (Infelizmente, não posso dizer que há algum que me agrade aqui.) Quais seriam mais propensos a considerar tomar medidas para “evitar resultados aprisionados/locked-in, permitindo que o progresso geral no mundo tivesse tempo de avançar, a fim de aumentar a probabilidade de ter bons resultados para todos”.

- Questões semelhantes se aplicam às pessoas e organizações que liderassem o desenvolvimento da Inteligência Artificial transformadora. Quais delas seriam mais prováveis de optar por uma direção positiva?

Algumas pessoas acham que podemos afirmar com confiança atualmente, quais países específicos e/ou quais pessoas e organizações gostaríamos que liderassem o desenvolvimento da Inteligência Artificial transformadora. Essas pessoas defenderiam medidas como:

- Aumentar as chances de que os primeiros sistemas PASTA sejam construídos em países que fossem, por exemplo, menos autoritários, o que significaria, por exemplo, pressionar por mais investimento e atenção ao desenvolvimento da Inteligência Artificial nesses países.

- Apoiar e tentar acelerar os laboratórios de Inteligência Artificial administrados por pessoas que provavelmente tomariam decisões sábias (tais como, envolvimento com governos, quais sistemas de Inteligência Artificial publicar e implantar contra manter em segredo, etc.)

Porque temo que a “competição” seja superestimada em relação à “cautela”

Por padrão, presumo que muitas pessoas gravitem em torno do modelo de “competição” em vez do modelo de “cautela” – por motivos que não considero bons, como:

- Acho que as pessoas ficam naturalmente mais animadas em “ajudar os mocinhos a vencer os bandidos” do que em “ajudar a todos nós a evitar um resultado universalmente ruim, por razões impessoais como ‘projetamos sistemas de Inteligência Artificial desleixados’ ou ‘criamos um sistema dinâmico onde a pressa e a agressividade são recompensadas.’”

- Espero que as pessoas tendam a ter excesso de confiança sobre quais países, organizações ou pessoas consideram os “mocinhos”.

- Abraçar o modelo de “competição” tende a apontar para medidas como – trabalhar para acelerar o desenvolvimento de Inteligência Artificial de um determinado país ou organização – que sejam lucrativas, emocionantes e naturalmente fáceis de engajar.

Abraçar o modelo de “cautela” é bem menos assim.

- As maiores preocupações que o modelo de “cautela” enfoca – Inteligência Artificial desalinhada e Maturidade Tecnológica Adversária – são um pouco abstratas e difíceis de entender. De muitas maneiras, elas parecem representar os riscos mais altos, mas é mais fácil sentir um medo visceral de “ficar atrás de países/organizações/pessoas que me assustam” do que sentir um medo visceral de “acabar com um resultado ruim no futuro da galáxia, porque apressamos demais as coisas neste século.”

- Acho que o risco da Inteligência Artificial desalinhada é particularmente difícil de ser levado a sério por muitas pessoas. Parece algo maluco ou uma narrativa de ficção científica; as pessoas que se preocupam com isso tendem a ser interpretadas como se imaginassem algo parecido com “O Exterminador do Futuro”, e pode ser difícil entender as suas preocupações mais específicas.

- Espero publicar mais postagens no futuro que ajudem a dar uma ideia intuitiva de porque acredito que a Inteligência Artificial desalinhada é um risco real.

Portanto, para evitar dúvidas, direi que acredito que o modelo de “cautela” tem muito a seu favor. Em particular, a Inteligência Artificial desalinhada e a Maturidade Tecnológica Adversária parecem muito piores do que outros tipos de transição em potencial, e ambos parecem coisas que têm uma chance real de fazer todo o futuro de nossa espécie (e nossos sucessores) muito piores do que poderiam ser.

Preocupa-me que muito do modelo de “competição” leve-nos a subestimar o risco de desalinhamento e a correr para implantar sistemas inseguros e imprevisíveis, o que teria muitas consequências negativas.

Dito isso, considero ambos os modelos seriamente importantes. No geral, continuo com muitas dúvidas de qual modelo seria mais importante e útil (se algum for).

Principais perguntas não respondidas sobre “cautela” vs. “competição”

Geralmente, as pessoas que seguem o modelo de “cautela” e as pessoas que adotam o modelo de “competição” favorecem ações muito diferentes e até contraditórias. Ações que parecem importantes para as pessoas em um modelo muitas vezes parecem ativamente prejudiciais para as pessoas no outro.

Por exemplo, as pessoas no modelo de “competição” geralmente preferem avançar o mais rápido possível no desenvolvimento de sistemas de Inteligência Artificial mais poderosos; para as pessoas no modelo de “cautela”, a pressa é uma das principais coisas a evitar. As pessoas no modelo de “competição” geralmente favorecem relações externas adversas, enquanto as pessoas no modelo de “cautela” geralmente desejam que as relações externas sejam mais cooperativas.

(Dito isto, essa dicotomia é uma simplificação. Muitas pessoas, inclusive eu, concordam com os dois modelos. E, qualquer um deles pode implicar em ações normalmente associadas ao outro; por exemplo, você pode ser adepto do modelo “cautela”, mas sente que a pressa é necessária agora a fim de estabelecer um país com uma liderança clara o suficiente em Inteligência Artificial para ter mais tempo, priorize evitar a Inteligência Artificial desalinhada, etc.)

Gostaria de poder dizer com confiança quanta importância colocar em cada modelo e quais ações provavelmente seriam úteis. Mas não posso. Acredito que teríamos mais clareza sobre isso se tivéssemos repostas melhores para algumas perguntas principais que ainda não foram respondidas:

Pergunta não respondida: quão difícil é o problema de alinhamento?

O pior caminho para o futuro é o da Inteligência Artificial desalinhada, no qual os sistemas de Inteligência Artificial acabariam com objetivos próprios não compatíveis com humanos e procurariam preencher a galáxia de acordo com esses objetivos. Quão seriamente devemos assumir esse risco — quão difícil seria evitar esse resultado? Quão difícil seria resolver o “problema de alinhamento”, significando ter essencialmente a capacidade técnica de construir sistemas que não farão isso?124

- Algumas pessoas acreditam que o problema de alinhamento será formidável; que nossa única esperança de o resolver acontecerá em um mundo onde teremos muito tempo e não estaremos em uma competição para implantar Inteligência Artificial avançada; e que evitar o resultado da “IA desalinhada” deve ser, de longe, a consideração dominante para o século mais importante. Essas pessoas tendem a favorecer fortemente as intervenções de “cautela” descritas acima: elas acreditam que acelerar o desenvolvimento da Inteligência Artificial aumenta nosso risco já substancial de ter o pior resultado possível.

- Algumas pessoas acreditam que será fácil e/ou que toda a ideia de “IA desalinhada” é equivocada, boba ou até mesmo incoerente — planejando um evento futuro excessivamente específico. Essas pessoas geralmente estão mais interessadas nas intervenções de “competição” descritas acima: elas acreditam que a Inteligência Artificial avançada provavelmente será usada eficazmente por qualquer país (ou em alguns casos coalizão, ou empresa menor) que a desenvolva primeiro e, portanto, a questão é quem será o primeiro a desenvolvê-la.

E muitas pessoas estão entre uma opinião e a outra.

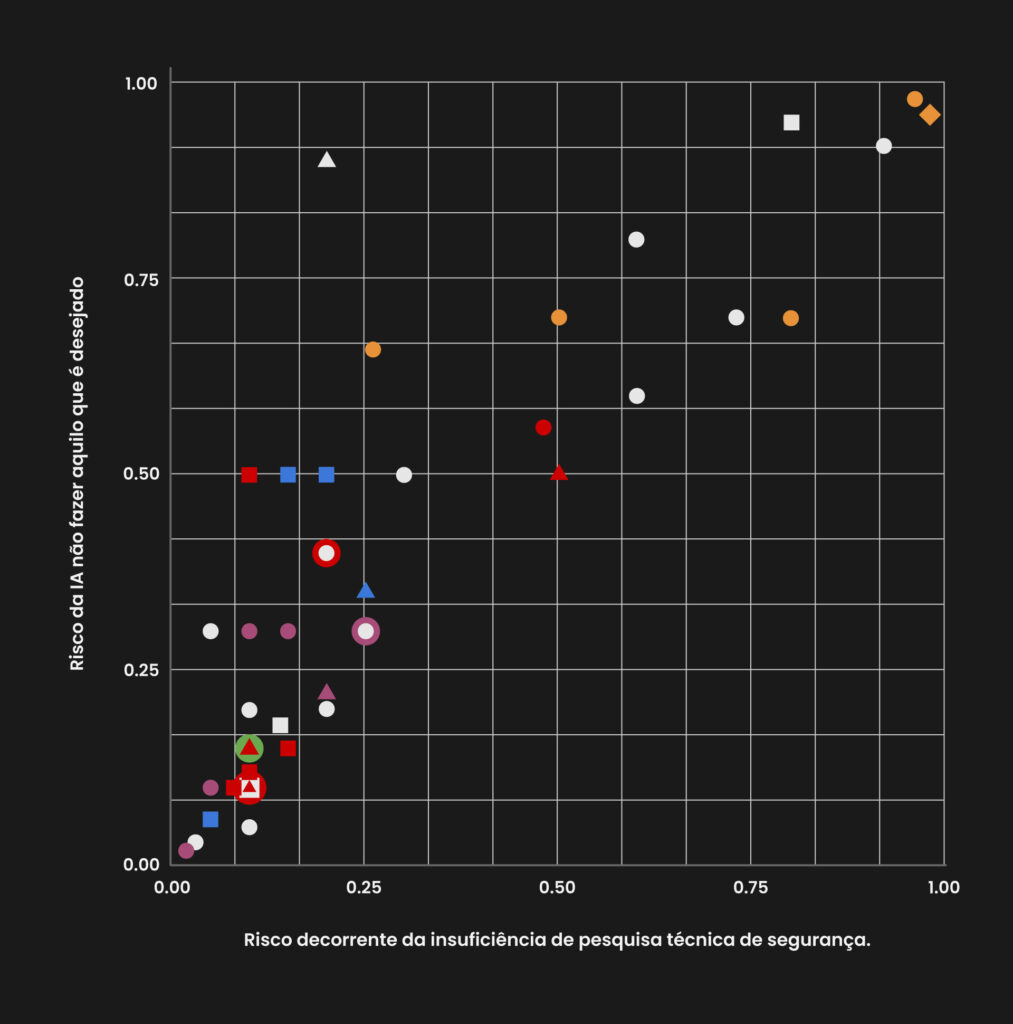

A propagação aqui é extrema. Por exemplo, veja estes resultados de uma “pesquisa de duas perguntas enviada informalmente para aproximadamente 117 pessoas que trabalham com risco de Inteligência Artificial de longo prazo, perguntando sobre o nível de risco existencial da ‘humanidade não fazer suficiente pesquisa técnica de segurança de Inteligência Artificial’ e de ‘sistemas de Inteligência Artificial que não estão fazendo/otimizando o que as pessoas que os implantaram queriam/pretendiam que eles fizessem.’” (Como mostra o gráfico de dispersão, as pessoas deram respostas semelhantes às duas perguntas.)

Temos entrevistados que acham haver menos de 5% de chance de que os problemas de alinhamento reduzam drasticamente o bem do futuro; respondentes que acham haver mais de 95% de chance; e quase de tudo no meio.125 Minha impressão é que esta é uma representação justa da situação: mesmo entre as poucas pessoas que passaram mais tempo pensando sobre esses assuntos, praticamente não há consenso ou convergência sobre o quão difícil será o problema do alinhamento.

Espero que, com o tempo, o campo de pesquisas sobre alinhamento de IA126 cresça e, à medida que as pesquisas sobre Inteligência Artificial e sobre o alinhamento avancem, entenderemos melhor qual é a dificuldade do problema de alinhamento de IA. Isso, por sua vez, esclareceria mais o tema de como priorizar “cautela” versus “competição”.

Outras perguntas não respondidas

Mesmo que tivéssemos clareza sobre a dificuldade do problema do alinhamento, muitas perguntas espinhosas permaneceriam.

Devemos esperar o desenvolvimento de uma Inteligência Artificial transformadora nos próximos 10 a 20 anos ou muito mais tarde? Os principais sistemas de Inteligência Artificial passarão de muito limitados a muito capazes rapidamente (hard takeoff) ou gradualmente (slow takeoff)?127 Devemos presumir que os projetos do governo desempenharão um papel importante no desenvolvimento da Inteligência Artificial ou que a Inteligência Artificial transformadora surgirá principalmente do setor privado? Alguns governos são mais propensos do que outros a trabalhar para que a Inteligência Artificial transformadora seja usada com cuidado, inclusão e humanidade? O que devemos esperar que um governo (ou empresa) faça literalmente se ganhar a capacidade de acelerar drasticamente o avanço científico e tecnológico por meio da IA?

Com essas e outras questões em mente, muitas vezes é difícil olhar para alguma ação – como abrir um novo laboratório de IA, defender mais cautela e salvaguardas no desenvolvimento atual de Inteligência Artificial, etc., e dizer se ela teria resultados positivos.

Ações vigorosamente úteis

Apesar desse estado de incerteza, aqui estão algumas medidas que, claramente, seriam de grande valor:

Pesquisa técnica sobre o problema de alinhamento. Alguns pesquisadores trabalham na construção de sistemas de Inteligência Artificial que podem obter “melhores resultados” (ganhar mais jogos de tabuleiro, classificar mais imagens corretamente, etc.) Mas um grupo menor de pesquisadores trabalha em coisas como:

- Treinar sistemas de Inteligência Artificial para incorporar feedback humano em como eles executam tarefas de resumo, para que os sistemas de Inteligência Artificial reflitam preferências humanas difíceis de definir — algo que seria importante que eles consigam fazer no futuro.

- Descobrir como entender “o que os sistemas de Inteligência Artificial estão pensando e como eles estão raciocinando,” para torná-los menos misteriosos.

- Descobrir como impedir que os sistemas de Inteligência Artificial façam julgamentos extremamente ruins sobre imagens projetadas para enganá-los, e outros trabalhos focados em ajudar a evitar os comportamentos de “pior caso” dos sistemas de IA.

- Trabalhos teóricos sobre como um sistema de Inteligência Artificial pode ser muito avançado, mas não ser imprevisível da maneira errada.

Esse tipo de trabalho reduziria o risco das consequências negativas da Inteligência Artificial desalinhada — e/ou conduziria a um melhor entendimento sobre o tamanho da ameaça. Alguns desses trabalhos são na academia, alguns em laboratórios de Inteligência Artificial e alguns em organizações especializadas.

Busca de clareza estratégica: fazer pesquisas que possam abordar outras questões cruciais (como as listadas acima), para esclarecer quais tipos de ações imediatas seriam mais úteis.

Ajudar governos e sociedades, a bem, melhorarem. Ajudar o País X a ficar à frente de outros no desenvolvimento de Inteligência Artificial pode melhorar ou piorar as coisas, pelas razões já apresentadas acima. Mas seria muito bom trabalhar a favor de um País X com valores melhores e mais inclusivos, e um governo cujos principais tomadores de decisão tenham maior probabilidade de tomar decisões ponderadas e baseadas em bons valores.

Disseminar ideias e construir comunidades. Hoje, parece-me que o mundo está extremamente carente de pessoas que compartilhem certas expectativas e preocupações básicas, como:

- Acreditar que a pesquisa de Inteligência Artificial pode levar a mudanças rápidas e radicais do tipo extremo apresentado aqui (muito além de coisas como, por exemplo, o aumento do desemprego).

- Acreditar que o problema do alinhamento (discutido acima) é pelo menos uma preocupação plausível e levar o modelo de “cautela” a sério.

- Analisar a situação pela perspectiva de “Vamos obter o melhor resultado possível para o mundo inteiro para o futuro de longo prazo”, em vez de perspectivas mais comuns, como “Vamos tentar ganhar dinheiro” ou “Vamos tentar garantir que a minha instituição/meu país seja o líder mundial em pesquisa de IA.”

Acho muito valioso que haja mais pessoas com essa perspectiva básica, principalmente trabalhando para laboratórios de Inteligência Artificial e governos. Se e quando tivermos mais clareza estratégica sobre quais ações maximizariam as chances de o “século mais importante” correr bem, espero que essas pessoas estejam relativamente bem-posicionadas para serem úteis.

Várias organizações e pessoas trabalharam para expor as pessoas às perspectivas acima e ajudá-las a conhecer outras pessoas que compartilham da mesma visão. Acho que boa parte do progresso (em termos de comunidades em crescimento) é resultado dessas ações.

Doar? Pode-se doar hoje para lugares como este. Mas preciso admitir que, falando de maneira muito ampla, não há uma tradução fácil agora entre “dinheiro” e “melhorar as chances de que o século mais importante corra bem”(o que isso quer dizer?). Não é o caso que, se alguém simplesmente enviasse, digamos, US$ 1 trilhão para o lugar certo, todos poderíamos respirar tranquilos sobre desafios como o problema de alinhamento e os riscos de distopias digitais.

Parece-me que nós — como espécie — estamos terrivelmente carentes de pessoas que prestem atenção aos desafios mais importantes à nossa frente, e não trabalhamos para ter uma boa clareza estratégica sobre quais ações tangíveis tomar. Não podemos resolver esse problema com dinheiro.128 Primeiro, precisamos levá-lo mais a sério e entendê-lo melhor.

Notas

116De Prevendo a Inteligência Artificial Transformadora: qual é o ônus da prova?: prevejo mais de 10% de chance da Inteligência Artificial transformadora ser desenvolvida dentro de 15 anos (até 2036); aproximadamente 50% em 40 anos (até 2060); e uma chance de aproximadamente 2/3 de ser desenvolvida neste século (até 2100).

117Isso inclui os livros Superintelligence, Human Compatible, Life 3.0, e The Alignment Problem. A apresentação mais curta e acessível que conheço é The case for taking AI seriously as a threat to humanity (Artigo na Vox por Kelsey Piper). Este report on existential risk from power-seeking AI (relatório sobre o risco existencial de uma Inteligência Artificial que visa poder) por Joe Carlsmith da Open Philanthropy, estabelece um conjunto detalhado de premissas que coletivamente implicariam que o problema é sério.

118A ordem de classificação não é absoluta, é claro. Existem versões de “Maturidade Tecnológica Adversária” que seriam piores do que “IA Desalinhada” — por exemplo, se a primeira resultar em poder indo para aqueles que deliberadamente infligem sofrimento.

119Parte da razão para isso é que os mais rápidos e menos cuidadosos acabariam superando rapidamente os outros e determinando o futuro da galáxia. Há também um risco de longo prazo discutido em The Future of Human Evolution (O futuro da evolução humana) de Nick Bostrom; veja também esta discussão das ideias de Bostrom no Slate Star Codex, mas também veja este artigo de Carl Shulman argumentando ser improvável que essa dinâmica resulte na eliminação total de coisas boas.

120Veja aqui

121Por exemplo, veja esta seção de Pessoas digitais seriam mais importantes ainda.

122Um artigo relevante: Public Policy and Superintelligent AI: A Vector Field Approach(Políticas públicas e Inteligência Artificial superinteligente: uma abordagem de campo vetorial)de Bostrom, Dafoe e Flynn.

123Maturidade tecnológica adversária refere-se a um mundo onde a tecnologia altamente avançada já foi desenvolvida, provavelmente com a ajuda da IA, e diferentes coalizões estão competindo por influência sobre o mundo. Por outro lado, “Competição” refere-se a uma estratégia de como se comportar antes do desenvolvimento de Inteligência Artificial avançada. Pode-se imaginar um mundo em que algum governo ou coalizão adota um quadro de “competição”, desenvolve Inteligência Artificial avançada muito antes de outros e, em seguida, toma uma série de boas decisões que impedem a Maturidade Tecnológica Adversária. (Ou, inversamente, um mundo onde o fracasso em se sair bem na “competição” aumenta os riscos de Maturidade Tecnológica Adversária.)

124Veja as definições deste problema na Wikipedia e no Medium de Paul Christiano.

125Uma pesquisa privada mais detalhada feita para este relatório, perguntando sobre a probabilidade de “desgraça” antes de 2070 devido ao tipo de problema discutido no relatório, obteve respostas variando de <1% a >50%. Na minha opinião, há pessoas muito ponderadas que consideraram seriamente esses assuntos em ambas as extremidades desse intervalo.

126Alguns exemplos de tópicos técnicos aqui.

127Algumas discussões sobre este tópico aqui: Distinção de definições de decolagem – AI Alignment Forum

128Mais algumas reflexões sobre “quando o dinheiro não é suficiente” nesta postagem antiga da GiveWell.