Ponto fraco de “O século mais importante”: automação completa

Agora que recebi algumas reações e críticas, achei que seria bom escrever algumas postagens cobrindo os que considero serem os pontos mais fracos da série “o século mais importante”.

Atualmente, acredito que o ponto mais fraco da série é mais ou menos assim:

- É verdade que se a Inteligência Artificial pudesse literalmente automatizar tudo o que fosse necessário para causar avanço científico e tecnológico, as consequências descritas na série (uma aceleração dramática no avanço científico e tecnológico, levando a um futuro radicalmente desconhecido) se concretizariam.

- E, se a Inteligência Artificial pudesse automatizar apenas 99% do que é necessário para o avanço científico e tecnológico? E se os sistemas de Inteligência Artificial pudessem propor experimentos, mas não conseguissem executá-los? E, se eles pudessem propor experimentos e executá-los, mas não conseguissem autorização regulatória para executá-los? Nesse caso, é plausível que 1% das coisas que as IAs não poderiam fazer de forma rápida e automática seriam um “gargalo” no progresso, levando a um crescimento drasticamente menor.

- A série cita a opinião de especialistas sobre quando a Inteligência Artificial transformadora será desenvolvida. Tecnicamente falando, o tipo de situação que os entrevistados estão prevendo — “máquinas independentes podem realizar todas as tarefas melhor e mais barato do que trabalhadores humanos” — deveria ser suficiente para uma explosão de produtividade. Mas os respondentes da pesquisa podem estar pensando em um tipo de Inteligência Artificial um pouco menos poderosa do que está literalmente implícito nessa afirmação — o que poderia levar a impactos drasticamente menores. Ou elas podem estar imaginando que mesmo IAs com capacidade intelectual comparável a dos humanos, podem ainda não ter a habilidade prática para realizar tarefas cruciais, porque (por exemplo) os humanos não confiam instintivamente nelas. De qualquer forma, eles (os entrevistados da pesquisa) podem estar imaginando algo quase tão capaz — mas não tão impactante — quanto o tipo de Inteligência Artificial que discuto aqui.

- Além disso, mesmo que as IAs conseguissem fazer tudo o que os humanos fazem para automatizar o avanço científico e tecnológico, seu progresso científico e tecnológico teria que aguardar os resultados de experimentos reais, o que poderia atrasá-los muito.

Resumindo: uma pequena lacuna no que a Inteligência Artificial pode automatizar pode levar a um impacto muito menor do que a série implica. Automatizar “quase tudo” seria muito diferente de automatizar tudo.

Este é um contexto importante para as tentativas de prever a Inteligência Artificial transformadora: eles estão realmente prevendo algo bastante extremo.

Minha resposta

Acho que tudo o que foi dito acima está correto: de fato, precisaríamos de níveis extremos de automação para produzir as consequências que imagino. (Pode haver algumas tarefas que precisam ser realizadas por humanos, mas elas devem ser um conjunto bem pequeno e limitado para evitar que as coisas fiquem muito lentas devido a gargalos.)

Também é verdade que não expliquei como essa automação extrema poderia ser alcançada — como cada atividade necessária para promover o avanço científico e tecnológico (incluindo a execução de experimentos e a espera de sua conclusão) poderia ser realizada de maneira rápida e/ou automatizada, sem gargalos humanos ou outros que atrasam muito as coisas.

Tendo reconhecido isso, também vale a pena ressaltar que os níveis extremos de automação não precisam se aplicar a toda a economia: a automação extrema para um conjunto relativamente pequeno de atividades seria suficiente para chegar às conclusões da série.

Por exemplo, poderia ser o suficiente para sistemas de Inteligência Artificial desenvolver: (a) computadores cada vez mais eficientes; (b) painéis solares (para energia); (c) robôs de mineração e manufatura; (d) sondas espaciais (para construir mais computadores no espaço, onde a energia e o metal são abundantes). Isso seria suficiente (via retroalimentação) para um crescimento explosivo na energia, materiais e poder de computação disponível, e há muitas maneiras pelas quais esse crescimento seria transformador.

Por exemplo, isso poderia levar a:

- IA desalinhada com acesso a quantidades perigosas de materiais e energia.

- Pessoas digitais, se os sistemas de Inteligência Artificial também tivessem alguma forma de

- “virtualizar” a neurociência (por meio de experimentos virtuais ou simplesmente aumentando dramaticamente a taxa de aprendizado de

- experimentos reais); ou (b) ter, por outro lado, uma visão sobre como criar algo que consideraríamos apropriadamente como “descendentes digitais”.

Conclusão

Acho que não demonstrei completamente (ou, para leitores com forte ceticismo inicial sobre esse ponto, convincentemente) que a Inteligência Artificial avançada causará uma aceleração explosiva no avanço científico e tecnológico, sem atingir “gargalos” dependentes dos humanos ou outros. Acho que dei uma boa noção da intuição de porque eles poderiam, mas esse é certamente um tópico no qual não me aprofundei o máximo que pude; espero e suponho que alguém o faça eventualmente.

Eu realmente acredito que essa cutucada acabará por corroborar o panorama que apresentei na série “século mais importante”. Isso é parcialmente baseado no raciocínio acima: o escopo relativamente limitado do que precisaria ser totalmente automatizado para sustentar minhas conclusões gerais. Também é parcialmente baseado em um processo de raciocínio semelhante ao que usei no passado para prever algumas conclusões principais antes de fazermos todo o dever de casa: envolver-se em muitas conversas e formar pontos de vista sobre o quão informados estão os diferentes grupos envolvidos e o quanto eles estão entendendo sobre isso. Mas reconheço que isso não é tão satisfatório ou confiável quanto seria se eu desse uma descrição altamente detalhada de quais atividades específicas poderiam ser automatizadas.

Ponto fraco de “O século mais importante”: aprisionamento/lock-in

Esta é a segunda de (por enquanto) duas postagens que cobrem os que considero serem os pontos mais fracos da série “o século mais importante”. (A primeira delas está aqui.)

O ponto fraco que abordarei aqui é a discussão sobre o “aprisionamento/lock-in”: a ideia de que a Inteligência Artificial transformadora poderia levar a sociedades estáveis por bilhões de anos. Se for verdade, isso significaria que o andamento das coisas neste século afetaria como a vida seria, de maneiras previsíveis e sistemáticas por períodos insondáveis.

Minha cobertura principal deste tópico está em uma seção do meu artigo sobre pessoas digitais. É bastante superficial, não está supercompleto e não é embasado em um relatório técnico detalhado (embora eu faça um link para algumas observações informais do físico Jess Riedel feitas por ele quando ele trabalhava na Open Philanthropy). Overcoming Bias (Superando o viés) me criticou neste ponto, causando uma breve discussão na seção de comentários.

Não serei dramaticamente mais completo ou convincente aqui, mas direi um pouco mais sobre como o argumento geral do “século mais importante” é afetado se ignorarmos essa parte dele e um pouco mais sobre porque acho o aprisionamento um cenário plausível.

(Observe também que o “aprisionamento” será discutido com mais detalhes em um próximo livro de Will MacAskill, What We Owe the Future (O que devemos ao futuro).)

Ao longo deste artigo, usarei aprisionamento/lock-in para significar que coisas importantes sobre a sociedade, como quem está no poder ou quais religiões/ideologias são dominantes, são aprisionadas no lugar indefinidamente, plausivelmente por bilhões de anos” e “dinamismo” ou “instabilidade” para significar o oposto: “tais coisas mudam em horizontes de tempo muito mais curtos, como em décadas/séculos/milênios”. Como observado anteriormente, considero o aprisionamento/lock-in uma possibilidade assustadora por definição, embora seja imaginável que certos tipos de aprisionamento (por exemplo, de proteção aos direitos humanos) seriam bons.

“O século mais importante” sem aprisionamento

Primeiro, vejamos o que acontece se descartarmos toda essa parte do argumento e assumirmos que o aprisionamento não é uma possibilidade, mas ainda aceitar o resto das informações. Em outras palavras, presumimos que:

- Algo como o PASTA (IA avançada que automatiza o avanço científico e tecnológico) será provavelmente desenvolvida neste século.

- Isso, no que lhe concerne, levaria a um avanço científico e tecnológico explosivo, resultando em um mundo governado por pessoas digitais ou Inteligência Artificial desalinhada, ou qualquer outra coisa, de forma que será justo dizer que: “transitamos para um estado onde os humanos, tais como os conhecemos, não são mais a força principal nos eventos mundiais.”

- Isso não levaria a que nenhum aspecto particular do mundo fosse permanentemente imutável. Restariam bilhões de anos com muitos desenvolvimentos imprevisíveis.

Nesse caso, acredito que ainda há um sentido importante em que este seria o “século mais importante para a humanidade”: seria nossa última chance de moldar a transição de um mundo governado por humanos para um mundo governado por algo muito diferente dos humanos. Esta é uma das duas definições de “século mais importante” dadas aqui.

Mais amplamente, neste caso, acredito que há um sentido importante em que a série “o século mais importante” deve ser pensada como “Apontando para uma questão drasticamente subestimada; correta em suas implicações mais consequentes e controversas, senão em todos os detalhes”. Quando as pessoas falam sobre as questões mais importantes de nosso tempo (na verdade, mesmo quando estão falando especificamente sobre as prováveis consequências da Inteligência Artificial avançada), elas raramente incluem muita discussão sobre os tipos de questões enfatizadas nesta série; e deveriam fazê-lo, quer esta série esteja correta ou não, sobre a possibilidade de “aprisionamento/lock-in”.

Como observado aqui no final das contas, eu me preocupo mais se a série do “século mais importante” está correta nesse sentido — apontando para questões drasticamente subestimadas — do que sobre a probabilidade de seu título acabar descrevendo a realidade. (Embora eu me importe com ambas as coisas.) É por esta razão que acredito que a discussão relativamente leve sobre aprisionamento/lock-in é um “ponto fraco” menos importante do que escrevi, o que levanta questões sobre se a Inteligência Artificial avançada mudaria muito o mundo em muitos aspectos ou muito rapidamente.

Mas incluí a menção do aprisionamento/lock-in porque acredito ser uma possibilidade real e tornaria as apostas deste século ainda mais altas.

Dissecando o “aprisionamento”

Provavelmente existiram muitas pessoas na história (imperadores, ditadores) com enorme poder sobre sua sociedade, que gostariam de manter as coisas como estavam para sempre. Também pode ter havido momentos em que governos eleitos democraticamente teriam “aprisionado” pelo menos algumas coisas sobre sua sociedade para sempre, se pudessem.

Mas não conseguiram. Por que não?

Acho que as razões se enquadram em algumas categorias, e pessoas digitais (ou Inteligência Artificial desalinhada, mas vou me concentrar nas pessoas digitais para manter as coisas simples por enquanto) pode mudar um pouco o cenário.

Primeiro listarei os fatores que parecem particularmente suscetíveis de serem alterados pela tecnologia, depois um fator que parece menos suscetível.

Fatores que parecem particularmente suscetíveis de serem alterados pela tecnologia

Envelhecimento e morte. Qualquer pessoa poderosa tem que morrer em algum momento. Eles podem tentar transferir o poder para filhos ou aliados, mas muitas coisas mudam na transferência (e em períodos muito longos de tempo, há muitas transferências).

Pessoas digitais não precisariam morrer ou envelhecer. (Mais amplamente, avanços suficientes em ciência e tecnologia parecem prováveis de conseguir eliminar o envelhecimento e a morte, mesmo que não seja por meio de pessoas digitais.) Portanto, se algum conjunto específico deles tivesse poder sobre alguma parte específica da galáxia, a morte e o envelhecimento não precisariam interferir aqui.

Outras mudanças populacionais. Com o tempo, a composição de qualquer população muda e, em particular, uma geração substitui a anterior. Isso tende a levar a mudanças de valores e dinâmicas de poder.

Sem envelhecimento ou morte, e com produtividade extrema, acabaríamos esgotando rapidamente a capacidade de carga de qualquer área específica — de modo que essa área não sofreria nenhuma alteração na composição populacional (ou ocorreriam alterações muito menores e mais controladas do que estamos acostumados atualmente — não há casos em que toda uma geração é substituída por uma nova). A rotatividade geracional parece um grande impulsionador do dinamismo até hoje.

Caos. Até hoje, mesmo quando algum governo é oficialmente “responsável” por uma sociedade, ele tem uma capacidade muito limitada de monitorar e intervir em tudo o que está acontecendo. Mas acredito que o avanço tecnológico até hoje já aumentou muito a capacidade de um governo de exercer controle sobre inúmeras pessoas e um vasto território. Uma explosão no avanço científico e tecnológico aumentaria ainda mais radicalmente o controle, na prática, dos governos sobre o que acontece.

(Pessoas digitais fornecem um exemplo extremo: controlar o servidor que roda um ambiente virtual significaria conseguir monitorar e controlar tudo sobre as pessoas naquele ambiente. E figuras poderosas conseguiriam criar muitas cópias de si mesmas para monitoramento e execução.)

Eventos naturais Todos os tipos de coisas podem perturbar uma sociedade humana: mudanças no tempo/clima, falta de recursos, etc. Avanços suficientes em ciência e tecnologia podem levar esse tipo de disrupção a níveis extremamente baixos (e, em particular, pessoas digitais têm necessidades de recursos bastante limitadas, de modo que não precisariam de recursos por bilhões de anos).

Busca por aperfeiçoamento Enquanto alguns ditadores e imperadores prefeririam manter as coisas como estão para sempre, a maioria dos governos atuais não tende a ter isso como uma aspiração: os funcionários eleitos se consideram responsáveis perante grandes populações cujas vidas estão tentando melhorar.

Mas avanços dramáticos em ciência e tecnologia significariam dramaticamente mais controle sobre o mundo, bem como potencialmente menos espaço para melhorias adicionais (suponho que a velocidade das melhorias deva diminuir em algum momento). Isso tornaria cada vez mais provável que algum governo ou organização decida que prefere manter as coisas como estão.

Mas esses fatores poderiam ser eliminados tão completamente a ponto de causar estabilidade por bilhões de anos? Acho que sim, se uma parcela suficiente da sociedade fosse digital (por exemplo, pessoas digitais), de modo que aqueles que buscam estabilidade usassem a correção digital de erros (essencialmente, fazer várias cópias de qualquer coisa importante, que seria usada para reverter qualquer mudança que aconteça, por qualquer motivo — para saber mais, veja as observações informais de Jess Riedel, que defende que a correção digital de erros poderia ser usada para atingir níveis bastante extremos de estabilidade).

Um exemplo tangível aqui seria ambientes virtuais rigidamente controlados, contendo pessoas digitais, programados para reiniciar totalmente (ou reiniciar propriedades principais) qualquer elemento principal que tivesse sido alterado. Estes exemplos representam uma maneira hipotética de eliminar, essencialmente, todos os fatores acima como fontes de mudança.

Mas mesmo que prefiramos evitar pensar em tais cenários específicos, penso que há casos mais amplos para avanços científicos e tecnológicos explosivos, reduzindo radicalmente o papel de cada um desses fatores, conforme descrito acima.

É claro que só porque algum governo conseguiu conquistar o “aprisionamento” isso não quer dizer que ele o faria. Mas após um longo tempo, as sociedades contra-aprisionamento simplesmente teriam cada vez mais oportunidades de se tornarem sociedades pró-aprisionamento, enquanto mesmo alguns poucos anos de uma sociedade “pró-aprisionamento” resultaria em aprisionamento por tempo indefinido. (E em um mundo de pessoas digitais operando muito mais rápido que os humanos, muito “tempo” poderia passar até o final deste século.)

Um fator que parece particularmente suscetível de ser alterado pela tecnologia: competição entre sociedades

Mesmo que um governo tivesse controle total sobre sua sociedade, isso não garantiria estabilidade, porque ele sempre poderia ser atacado por agentes externos. E ao contrário dos fatores acima, isso não é nada que avanços radicais em ciência e tecnologia parecem particularmente propensos a mudar: em um mundo de pessoas digitais, diferentes governos ainda conseguiriam se atacar reciprocamente e negociar entre si, tendo a ameaça de ataque ao fundo.

Isso causaria uma instabilidade permanente, de modo que o mundo estaria em constante mudança. Este é o ponto enfatizado pela crítica do Overcoming Bias (Superando o viés).

Acho que essa dinâmica poderia — ou não — ser uma fonte duradoura de dinamismo. Algumas razões pelas quais isso pode não acontecer:

- Se a Inteligência Artificial causar uma explosão no avanço científico e tecnológico, quem a desenvolvesse primeiro rapidamente se tornaria muito poderoso — ser “o primeiro a desenvolver o PASTA em alguns meses” significaria, efetivamente, o mesmo que desenvolver o equivalente à conquista de vários séculos de liderança em ciência e tecnologia depois disso. Isso levaria à consolidação do poder na Terra, e não há sinais de vida inteligente fora da Terra — então seria o fim da dinâmica do “ataque” como força de instabilidade.

- A consciência do risco mencionado acima, faria com que as principais potências negociassem e dividissem explicitamente a galáxia, comprometendo-se (talvez forçosamente,dependendo de como o panorama tecnológico tiver sido abalado) para nunca invadir o território um do outro. Nesse caso, qualquer parte específica da galáxia estaria livre de ataques.

- Pode acontecer que os assentamentos espaciais sejam geralmente mais fáceis de defender do que atacar, de modo que, uma vez que alguém os estabeleça, eles essencialmente não estarão sujeitos a ataques.

Qualquer um dos itens acima, ou uma combinação deles (por exemplo, ataques são possíveis, mas arriscados e caros; as potências mundiais optam por não atacar umas às outras para não desencadear uma guerra) levariam ao desaparecimento permanente da competição militar como um fator, e abririam a possibilidade de alguns governos “aprisionarem” características-chave de suas sociedades.

Três categorias de futuro de longo prazo

Acima, listei alguns fatores que poderiam — ou não — continuar sendo fontes de dinamismo mesmo após um avanço científico e tecnológico explosivo. Acho que comecei a entender por que, no mínimo, as fontes de dinamismo seriam muito reduzidas no caso de pessoas digitais ou outras tecnologias radicalmente avançadas, em comparação com o que temos atualmente.

Agora quero dividir os diferentes futuros possíveis em três grandes categorias:

Aprisionamento discricionário total. É aqui que um determinado governo (ou coalizão, ou configuração negociada) consegue aprisionar, essencialmente, quaisquer propriedades que escolher para sua sociedade, indefinidamente.

Isso pode acontecer se essencialmente todas as fontes de dinamismo descritas

acima desaparecerem e os governos optarem por buscar o aprisionamento.

Dinâmica competitiva previsível. Acho que a fonte de dinamismo com maior probabilidade de persistir (em um mundo de pessoas digitais ou ciência e tecnologia comparativamente avançadas) é a última discutida na seção acima: competição militar entre sociedades avançadas.

No entanto, acredito que persistiria de uma forma que tornaria os resultados de longo prazo previsíveis. Na verdade, acho que “resultados de longo prazo previsíveis de uma forma importante” fazem parte da visão implícita na crítica do Overcoming Bias (Superando o viés), que argumenta que o mundo precisará ser quase exclusivamente povoado por seres que passem quase toda a existência trabalhando (já que a população crescerá a ponto de ser preciso trabalhar constantemente para sobreviver).

Se todos os seres digitais controlassem tudo no mundo, exceto se precisassem lutar contra outros países, isso poderia causar grandes problemas para os seres digitais que são mais ambiciosos, produtivos, trabalhadores e agressivos. Estes seriam seres que fariam pouco mais do que apenas lutar por recursos.

Dinamismo verdadeiro. Em vez de um mundo onde governos confiscam propriedades arbitrariamente ou seres digitais competem com resultados previsíveis, poderíamos ter um mundo com verdadeira liberdade e dinamismo. Isso poderia ser alcançado por meio de medidas que impeçam o confisco e a competição desenfreada, promovendo a diversidade e até mesmo a aleatoriedade.

E acabarmos vivendo em qualquer um desses três mundos, e este século determinar em qual (ou qual mistura) deles viveremos, isso constitui um bom argumento a favor da ideia de que este século teria impactos especialmente notáveis, e, portanto, ele seria o século mais importante de todos os tempos para a vida inteligente.

Por exemplo, do ponto de vista atual, temos a mesma probabilidade de (a) viver em um mundo onde governos poderosos utilizariam o aprisionamento, (b) viver em um mundo onde a competição desenfreada levaria a galáxia a dominação pelos seres mais fortes/produtivos/agressivos, ou (c) um mundo verdadeiramente dinâmico onde eventos futuros seriam imprevisíveis e importantes.

Nesse caso, se terminarmos com (c), e os eventos futuros acabarem sendo extremamente interessantes e consequentes, eu pensaria que ainda haveria um sentido importante em que o desenvolvimento mais importante de todos os tempos fosse o estabelecimento dessa mesma dinâmica. (Dado que uma das outras duas alternativas acabaria determinando a forma da civilização em toda a galáxia, a longo prazo.) Outra forma de dizer isso: se o aprisionamento/lock-in (e/ou previsivelmente a dinâmica competitiva) for uma possibilidade séria a partir deste século, a oportunidade de evitá-lo tornaria este século o mais importante.

Resumindo

Forneci muitos detalhes a respeito de futuros radicalmente desconhecidos, e os leitores podem estar com a sensação neste ponto, que as coisas ficaram muito específicas e complexas para serem consideradas seriamente. Mas acho que as intuições gerais aqui são bastante simples e sólidas, então darei um resumo de alto nível:

- Avanço científico e tecnológico reduziria ou eliminaria muitas das fontes atuais de instabilidade, desde o envelhecimento e a morte até o caos e eventos naturais. Uma explosão no avanço científico e tecnológico poderia, portanto, levar a uma grande redução do dinamismo. (E como um exemplo vívido, as pessoas digitais configurariam ambientes virtuais rigidamente controlados com correção de erros muito robusta, algo que considero uma possibilidade assustadora por padrão, conforme observado na introdução.)

- O dinamismo permaneceria ou não, dependendo de uma série de fatores sobre como o poder acabaria sendo consolidado e como diferentes governos/sociedades se relacionariam entre si. O “é possível ou não é” seria determinado neste século.

- Acho que esta é uma possibilidade séria o suficiente para aumentar as apostas a favor do “século mais importante”, mas não estou muito confiante nesse pensamento aqui, e acredito que a maior parte do espírito da hipótese do “século mais importante” sobrevive mesmo se nos esquecermos de tudo isso.

Espero que essas considerações adicionais tenham fornecido um contexto útil sobre o que quero dizer, mas continuo reconhecendo que esta é uma das partes menos desenvolvidas da série e estou interessado em explorar mais o assunto.

“Âncoras biológicas” é sobre delimitar e, não, apontar, cronologias da IA

Anteriormente resumi o método das “âncoras biológicas” para a previsão da Inteligência Artificial transformadora de Ajeya Cotra, também conhecido como “Bio-âncoras.” Aqui, quero tentar esclarecer por que considero esse método tão útil, embora concorde com a maioria das coisas específicas que ouvi as pessoas dizerem sobre seus pontos fracos (às vezes, pessoas que não conseguem entender por que eu daria qualquer importância a ela).

Algumas considerações preliminares:

- Provavelmente, esta postagem é de interesse, principalmente, dos céticos a respeito da teoria das Bio-âncoras e/ou pessoas que se sentem muito confusas/agnósticas sobre seu valor e gostariam de ler uma resposta dada aos céticos.

- Não quero dar a impressão de que estou fazendo novas críticas ao “Bio-âncoras” e pressionando por uma nova reinterpretação. Acho que a autora de “Bio-âncoras” concorda com a maioria do que digo sobre os pontos fracos do relatório e sobre como usá-lo melhor

Um resumo do que se trata o método

Apenas para restabelecer o contexto, aqui estão algumas citações importantes da minha postagem principal sobre o método das âncoras biológicas:

A ideia básica é:

Os modelos modernos de IA podem “aprender” a realizar tarefas por meio de um processo (financeiramente caro) conhecido como “treinamento”. Você pode pensar no treinamento como uma enorme quantidade de tentativa e erro. Por exemplo, os modelos de IA de reconhecimento de voz recebem um arquivo de áudio de alguém falando, adivinham o que a pessoa está dizendo e recebem a resposta certa. Ao fazer isso milhões de vezes, eles “aprendem” a traduzir de forma confiável a fala em texto. Mais: Treinamento

Quanto maior for um modelo de IA e mais complexa a tarefa, mais caro será o processo de treinamento [ou “rodada de treinamento”]. Alguns modelos de IA são maiores que outros; até o momento, nenhum deles chega nem perto de ser “tão grande quanto o cérebro humano” (o que isso significa será explicado a seguir).

Mais: Tamanho do modelo e tipo de tarefa

O método das âncoras biológicas pergunta: “Com base nos padrões usuais, quanto custaria treinar um modelo de Inteligência Artificial tão grande quanto um cérebro humano para executar as tarefas mais difíceis que os humanos conseguem fazer? E quando isso será barato o suficiente para que alguém faça esse treinamento?”

Mais: Estimando os custos

… O método propõe uma maneira de pensar sobre como pode ser simultaneamente verdadeiro que (a) os sistemas de Inteligência Artificial de uma década atrás não pareciam muito surpreendentes; (b) os sistemas de Inteligência Artificial atuais conseguem fazer muitas coisas surpreendentes, mas parecem ainda muito aquém do que os humanos conseguem fazer; (c) o desenvolvimento da Inteligência Artificial transformadora poderá, facilmente, acontecer nas próximas décadas – ou mesmo nos próximos 15 anos.

Além disso, acredito que vale a pena observar alguns argumentos de alto nível do Bio-âncoras que não dependem de tantas estimativas e suposições:

- Na próxima década, provavelmente veremos – pela primeira vez – modelos de Inteligência Artificial com “tamanho” comparável ao do cérebro humano.

- Se os modelos de Inteligência Artificial continuarem a se tornar maiores e mais eficientes nas taxas que o Bio-âncoras estima, provavelmente se tornará econômico neste século atingir alguns marcos bastante extremos – o “ponto alto” do que a Bio-âncoras acha que seria necessário. Estes são difíceis de resumir, mas veja as estruturas de “rede neural de horizonte longo” e “âncora de evolução” no relatório.

- Uma maneira de pensar sobre isso é que no próximo século passaremos provavelmente de “computação insuficiente para executar um modelo de tamanho humano” para “computação extremamente abundante, tanto quanto estimativas bastante conservadoras do que podemos precisar.” O poder computacional não é o único fator no progresso da IA, mas a medida que outros fatores (algoritmos, processos de treinamento) forem se tornando novos gargalos, provavelmente haverá incentivos poderosos (e várias décadas) para resolvê-los.

Pontos com os quais concordo sobre as fraquezas/limitações do método

O Bio-âncoras “age como se” a Inteligência Artificial fosse desenvolvida de uma maneira específica, e quase certamente ela não será

O Bio-âncoras, em um certo sentido, “age como se” a Inteligência Artificial transformadora fosse construída de uma maneira específica: simples tentativa e erro de força bruta de tarefas computacionalmente intensivas (conforme descrito aqui). Suas principais previsões são baseadas nesse panorama: o método estima quando haverá computação suficiente para executar uma certa quantidade de tentativa e erro e chama isso de “estimativa de quando a Inteligência Artificial transformadora será desenvolvida”.

Acho improvável que, se, e quando, a Inteligência Artificial transformadora for desenvolvida, como ela será desenvolvida se assemelhará a esse tipo de tentativa e erro cego de tarefas de horizonte longo.

Se eu tivesse que prever como a Inteligência Artificial transformadora será desenvolvida, seria mais parecido com isso aqui:

- Primeiro, os sistemas de Inteligência Artificial restrito provam seu valor na realização de um conjunto limitado de tarefas. (Isso já está acontecendo, em um grau limitado, por exemplo, nas tarefas de reconhecimento de voz, tradução e buscas).

- Isso levaria a (a) mais atenção e financiamento para IA; (b) maior integração da Inteligência Artificial na economia, de modo que seja mais fácil coletar dados sobre como os humanos interagem com as IAs, que poderiam ser usados para treinamento adicional; (c) maior conscientização geral sobre o que seria necessário para a Inteligência Artificial automatizar tarefas principais de maneira útil e, portanto, maior conscientização (e atenção) das maiores barreiras que impedem a Inteligência Artificial de ser mais ampla e capaz.

- Diferentes tipos de AIs restritas se integrariam em diferentes setores da economia. Com o tempo, o aumento de dados de treinamento, financiamento e atenção conduziria a IAs cada vez menos restritas, assumindo partes cada vez mais amplas das tarefas que elas já estivessem realizando. Essas mudanças não acontecem apenas por meio de modelos de Inteligência Artificial (e execuções de treinamento) crescentes; elas também são impulsionadas por inovações em como as IAs são projetadas e treinadas.

- Em algum momento, alguma combinação de IAs conseguiria automatizar o suficiente o avanço científico e tecnológico para ser transformadora.

Não haveria uma única “rodada mestre” na qual uma única Inteligência Artificial seria treinada para executar as tarefas mais difíceis e amplas por meio de tentativa e erro cego.

O Bio-âncoras “age como se” a disponibilidade de poder computacional fosse o único grande obstáculo ao desenvolvimento da Inteligência Artificial transformadora, e ele, provavelmente, não é

Como observado na minha postagem anterior:

O Bio-âncoras pode ser considerado agressivo demais devido à sua suposição de que “o poder computacional é o gargalo”:

Ele pressupõe que, se alguém pudesse pagar por todo o poder computacional necessário para fazer o “treinamento” de força bruta, descrito acima para as tarefas principais,(por exemplo, automatizar o trabalho científico), a IA transformadora (provavelmente) seria desenvolvida em seguida.

Treinar um modelo de IA não requer apenas comprar poder computacional. Requer a contratação de pesquisadores, realização de experimentos e, talvez o mais importante, encontrar uma maneira de configurar o processo de “tentativa e erro” para que a IA possa obter um grande número de “tentativas” na tarefa principal. Pode acontecer que fazer isso seja proibitivamente difícil.

É muito fácil imaginar mundos onde o desenvolvimento da Inteligência Artificial transformadora leva muito mais, ou menos tempo do que o Bio-âncoras sugere para acontecer, por razões que, essencialmente, não foram modeladas no Bio-âncoras.

Conforme implícito acima, a Inteligência Artificial transformadora pode levar muito tempo para ser desenvolvida por motivos como “é extremamente difícil obter dados e ambientes de treinamento para algumas tarefas cruciais” ou “algumas tarefas simplesmente não podem ser aprendidas mesmo com abundantes rodadas de tentativa e erro.”

A Inteligência Artificial transformadora também poderia ser desenvolvida muito mais rapidamente do que o Bio-âncoras sugere. Por exemplo, algum avanço na forma como projetamos algoritmos de Inteligência Artificial – talvez inspirados pela neurociência – poderia levar ao desenvolvimento de IAs que conseguiriam fazer, praticamente, tudo o que o cérebro humano consegue, sem precisar da enorme quantidade de tentativa e erro que a Bio-âncoras estima (com base na extrapolação dos sistemas atuais de aprendizado de máquina).

Listei mais considerações como estas aqui.

O Bio-âncoras não está “apontando” o ano mais provável em que a Inteligência Artificial transformadora será desenvolvida

Minha compreensão dos modelos de mudança climática é que eles: tentam analisar cada fator principal que poderia aumentar ou abaixar a temperatura no futuro; então, produzir a melhor estimativa para cada um deles; e compilar todas essas previsões em uma previsão de como será a temperatura.

De certa forma, você pode considerá-las como “apontamento da melhor estimativa” (ou mesmo “simulação”) da temperatura futura: embora elas não sejam certas ou precisas, elas estão identificando uma temperatura específica com base nos principais fatores que poderiam aumentar ou diminuir a temperatura.

Muitos outros casos em que alguém estima algo incerto (por exemplo, a população futura) têm propriedades semelhantes.

O Bio-âncoras não é assim. Existem fatores que ele ignora serem identificáveis atualmente e, que, são quase certamente importantes. Portanto, em algum sentido importante, ele não está “apontando” o ano mais provável para o desenvolvimento da Inteligência Artificial transformadora.

(Este não é o foco deste artigo) As estimativas do Bio-âncoras são muito incertas

O Bio-âncoras estima algumas coisas difíceis de prever, como:

- Qual tamanho um modelo de Inteligência Artificial teria que ter, para que ele seja “tão grande quanto o cérebro humano”, em algum sentido relevante. (Para isso ele adapta o relatório detalhado de Joe Carlsmith.)

- Com que rapidez devemos esperar que a eficiência algorítmica, a eficiência do hardware e a “vontade de gastar muito com a IA” aumentem no futuro — tudo isso afeta a questão de “qual será o tamanho de uma rodada de Inteligência Artificial econômica”. Suas estimativas aqui são muito simples e acredito que há muito espaço para melhorias, embora não espere que o panorama qualitativo mude radicalmente.

Reconheço uma incerteza significativa nessas estimativas e reconheço que (desde que tudo seja igual) quando há incerteza isso significa que devemos ser céticos.

Dito isto:

- Acho que essas estimativas provavelmente estão razoavelmente próximas do melhor que podemos fazer atualmente com as informações que temos em nosso poder.

- Acho que elas são boas o suficiente para os propósitos do que direi abaixo sobre cronologias da Inteligência Artificial transformadora.

Não planejo defender mais esta posição aqui, mas posso fazê-lo no futuro caso receba muitas críticas.

O Bio-âncoras como uma forma de delimitar cronologias de IA

Após reconhecer todas as fraquezas acima, aqui estão alguns pontos em que acredito sobre as cronologias de IA, os quais são amplamente baseados na análise do Bio-âncoras:

- Eu ficaria pelo menos levemente surpreso se a Inteligência Artificial transformadora não fosse desenvolvida até 2060. Estimo em 50% a probabilidade do desenvolvimento da Inteligência Artificial transformadora até então, (explico abaixo como “leve surpresa” e “50%” se relacionam); eu poderia simpatizar com alguém que estimasse uma probabilidade de 25% ou 75%, mas teria dificuldade em entender as razões de alguém que estimasse algo fora desse intervalo. Mais

- Eu ficaria muito surpreso se a Inteligência Artificial transformadora não fosse desenvolvida até 2100. Estimo a probabilidade de isso acontecer até 2100 de 2/3; eu seria solidário com alguém que dissesse que seria 1/3 ou 80–90%, mas teria dificuldade em entender as razões de alguém que estimasse algo fora desse intervalo. Mais

- O desenvolvimento da Inteligência Artificial transformadora até 2036 parece plausível e concretamente imaginável, mas não parece uma boa expectativa padrão. Acho que a probabilidade disso acontecer até 2036 é de pelo menos 10%; eu seria solidário com alguém que dissesse que seria 40–50%, mas teria dificuldade em entender as razões de alguém que dissesse que seria<10% ou >50%. Mais

Eu ficaria pelo menos levemente surpreso se a Inteligência Artificial transformadora não fosse desenvolvida até 2060.

Principalmente porque, segundo o Bio-âncoras, será econômico realizar algumas rodadas de treinamento absurdamente grandes. Sem dúvida, as maiores que alguém pudesse imaginar um dia precisar fazer, com base no uso de modelos de Inteligência Artificial com 10x o tamanho dos cérebros humanos e tarefas que requerem inúmeros cálculos para serem feitas até mesmo uma única vez.

Em algum sentido importante, disporemos de poder computacional em abundância. (Mais sobre esta intuição em Fun with +12 OOMs of compute (Diversão com mais de doze ordens de magnitude de computação.)

Mas também é importante que 2060 seja daqui a 40 anos, ou seja, que tenhamos 40 anos para:

- Desenvolver algoritmos de Inteligência Artificial cada vez mais eficientes, alguns dos quais seriam grandes avanços.

- Aumentar o número de empresas e negócios centrados em IA, coletando dados sobre a interação humana e concentrando cada vez mais atenção nas coisas que atualmente são obstáculo para aplicações mais amplas.

Dada a quantidade crescente de investimentos, talentos e potenciais aplicações para os sistemas de Inteligência Artificial atuais, 40 anos parece um tempo muito longo para ter grandes progressos nessas frentes. Para contextualizar, 40 anos é o tempo decorrido entre o lançamento do Apple IIe e agora.

Quando se trata de traduzir minha “sensação de leve surpresa” em uma probabilidade (veja aqui para ter uma noção do que estou tentando fazer ao falar sobre probabilidades; espero escrever mais sobre este tópico no futuro):

- Na maioria dos tópicos, eu igualo “eu ficaria um pouco surpreso se X não acontecesse” com algo como uma probabilidade de 60-65% de X. Mas, neste tópico, acredito que há um ônus da prova (o que considero importante, embora não seja excessivo), e estou inclinado a abaixar um pouco as minhas estimativas. Então, estou dizendo haver cerca de 50% de probabilidade de termos a Inteligência Artificial transformadora até 2060.

- Eu seria solidário se alguém dissesse “40 anos não parece o suficiente para mim; acredito que há mais de 25% de probabilidade de termos uma Inteligência Artificial transformadora até 2060.” Mas se alguém colocasse a probabilidade em menos de 25%, eu começaria a pensar: “É mesmo? De onde você tirou isso? Em meio ao boom atual da Inteligência Artificial, é razoável se perguntar por que há menos de 25% de probabilidade de desenvolvermos a Inteligência Artificial transformadora em um ano. Considerando que, segundo nossas melhores estimativas, teremos poder computacional suficiente para realizar as maiores rodadas necessárias, e ainda teremos 40 anos até 2060 para resolver muitos dos outros obstáculos, é importante reavaliar essa probabilidade.

- Por outro lado, eu seria solidário com alguém que dissesse “Esta estimativa parece muito conservadora; 40 anos devem ser suficientes; Acho que há mais de 75% de probabilidade de termos uma Inteligência Artificial transformadora até 2060.” Mas se alguém colocasse a probabilidade em mais de 75%, eu começaria a pensar: “É mesmo? De onde você tirou isso? A Inteligência Artificial transformadora não parece próxima, então me parece muita confiança em um evento daqui a 40 anos.”

Eu ficaria muito surpreso se a Inteligência Artificial transformadora não fosse desenvolvida até 2100

Até 2100, o Bio-âncoras prevê que será econômico, não apenas realizar rodadas de treinamento quase comicamente grandes (novamente com base no tamanho hipotético dos modelos e custo por tentativa das tarefas), mas para realizar tantos cálculos quanto todos já feitos por todos os animais da história juntos, a fim de recriar o progresso feito pela seleção natural.

Além disso, 2100 é daqui a 80 anos — mais do que o tempo decorrido desde que os computadores digitais programáveis foram desenvolvidos inicialmente. É muito tempo para encontrar novas abordagens para algoritmos de IA, integrar a Inteligência Artificial na economia, coletar dados de treinamento, lidar com casos em que os atuais sistemas de Inteligência Artificial não conseguem aprender tarefas específicas, etc.

Para mim, parece que 2100 é algo como “O ponto mais longe no tempo para contar uma história aparentemente razoável, e mais um pouco”. Consequentemente, eu ficaria muito surpreso se a Inteligência Artificial transformadora não fosse desenvolvida até então, e atribuo cerca de 2/3 de probabilidade de que ela será. E:

- Eu seria solidário com alguém que dissesse “Bem, há muito que não sabemos e muito que ainda precisa acontecer — só acredito que há 50% de probabilidade de termos uma Inteligência Artificial transformadora até 2100”. Eu seria até um pouco compreensivo se eles dessem uma probabilidade de 1/3. Mas se alguém colocasse a probabilidade em menos de 1/3, eu realmente teria problemas para entender as suas razões para isso.

- Eu seria solidário se alguém colocasse a probabilidade do desenvolvimento da “IA transformadora até 2100” em mais ou menos 80–90%, mas dada a dificuldade de prever esse tipo de coisa, eu realmente teria problemas para entender as suas razões se eles passassem de 90%.

A Inteligência Artificial transformadora até 2036 parece plausível e concretamente imaginável, mas não parece uma boa expectativa padrão.

O Bio-âncoras apresenta cenários concretos e plausíveis nos quais há suficiente poder computacional econômico para treinar a Inteligência Artificial transformadora até 2036 (link). Conheço alguns pesquisadores de Inteligência Artificial que acham que esses cenários são mais do que plausíveis — suas intuições dizem a eles que as rodadas gigantes de treinamento imaginadas pelo Bio-âncoras são desnecessárias e que as âncoras mais agressivas no relatório estão sendo subestimadas.

Também acredito que o Bio-âncoras subestima um pouco o caso para a “IA transformadora até 2036”, porque é difícil dizer quais consequências o atual boom de investimento e interesse em Inteligência Artificial terá. Se a Inteligência Artificial está prestes a se tornar uma parte visivelmente maior da economia (definitivamente um “se”, mas compatível com as tendências recentes do mercado), isso resultaria em rápidas melhorias em muitas dimensões possíveis.

Uma relação de retroalimentação positiva poderia existir na qual novos aplicativos lucrativos de Inteligência Artificial estimulassem maiores investimentos em IA. Isso, por sua vez, poderia levar a melhorias mais rápidas do que o esperado na eficiência dos algoritmos e da computação de IA, o que, em última análise, resultaria em aplicativos mais lucrativos.…

Considerando todos esses fatores, acredito que a probabilidade do desenvolvimento da Inteligência Artificial transformadora até 2036 é de pelo menos 10%, e não tenho muita simpatia por alguém que diga que ela é menor.

E dito isto, tudo o que foi dito acima é um conjunto de “poderia ser” e “poderia acontecer” – todos os casos que ouvi de “IA transformadora até 2036” parecem exigir uma série de etapas incertas a serem resolvidas.

- Se tarefas de “longo-prazo” se tornarem importantes, o Bio-âncoras mostra que é difícil imaginar que haverá computação suficiente para as rodadas de treinamento necessárias.

- Mesmo que haja muito poder computacional disponível, 15 anos podem não ser tempo suficiente para resolver desafios como reunir os dados e ambientes de treinamento corretos.

- É certamente possível que algum paradigma completamente diferente surja – talvez inspirado pela neurociência – e a Inteligência Artificial transformadora seja desenvolvida de maneiras que não requeiram “rodadas de treinamento” do tipo Bio-âncoras. Mas não vejo nenhuma razão em particular para esperar que isso aconteça nos próximos 15 anos.

Portanto, também não simpatizo muito com as pessoas que pensam que há mais de 50% de probabilidade de uma Inteligência Artificial transformadora ser desenvolvida até 2036.

Conclusão

O método das Bio-âncoras é um pouco diferente da abordagem “comum” para estimar as coisas. Ele não “aponta” datas prováveis para a Inteligência Artificial transformadora; ele não modela todos os fatores-principais.

Mas acredito que ele é muito útil — em conjunto com o raciocínio informal sobre os fatores que ele não modela — para “delimitar” cronologias da Inteligência Artificial transformadora: fazer uma variedade de declarações do tipo “Seria surpreendente se a Inteligência Artificial transformadora não fosse desenvolvida até a data X” ou “Você poderia defender uma porcentagem de probabilidade X até tal data, mas acredito que seria difícil simpatizar com uma porcentagem de probabilidade Y”.

E, esse tipo de “delimitação” parece bastante útil para o propósito que mais me interessa: decidir com que seriedade levar a possibilidade do século mais importante. Minha opinião é que essa possibilidade é muito séria, embora longe de ser uma certeza, e o Bio-âncoras é uma parte importante desse panorama para mim.

Mais sobre “Múltiplas economias de tamanho mundial por átomo”:

Uma continuação de “Isto não pode continuar” para os céticos.

Em Isto não pode continuar, eu argumentei que mais 8.200 anos da taxa de crescimento de hoje exigiriam que sustentássemos “múltiplas economias tão grandes quanto a economia mundial inteira de hoje por átomo”.

O feedback sobre este trecho foi dividido entre “Isso é obviamente impossível, 8200 anos de crescimento de 2% é uma ideia absurda — o crescimento terá que diminuir muito antes disso” e “Por que isso seria impossível? Com criatividade crescente, poderíamos aumentar cada vez mais a qualidade de vida, sem a necessidade de usar cada vez mais recursos materiais.”

Aqui responderei ao último ponto, o que significa explicar porque 8.200 anos de crescimento de 2% não parece uma coisa razoável de se esperar. Farei muitas suposições extremamente audaciosas e falarei sobre todos os tipos de possibilidades estranhas, apenas para poder abordar até mesmo maneiras rebuscadas para que o crescimento de 2% continue.

Se você já está no time dos que dizem “Sim, não vejo a economia mundial crescendo tanto assim”, você deve pular esta postagem, a menos que goste de ver o caso construído com uma quantidade razoável de detalhes.

Como PODERÍAMOS sustentar “múltiplas economias de tamanho mundial por átomo”

Eu realmente acho que seja concebível que poderíamos sustentar “múltiplas economias de tamanho mundial por átomo”. Aqui está uma forma de fazer isso:

Digamos que descobrimos alguma nova atividade, ou experiência, ou droga, que as pessoas realmente, realmente, REALMENTE valorizam.

Especificamente, o mercado avalia essa descoberta em 1085 dos dólares americanos de hoje (isso é dez trilhões de trilhões de trilhões de trilhões de trilhões de trilhões de dólares). Isso significa que ela vale cerca de, 1071 vezes mais do que tudo o que o mundo produz em um ano atualmente (junto).130

Então, uma pessoa tendo essa experiência131 significaria que o tamanho da economia é de pelo menos US$ 1085. E isso seria, de fato, o equivalente a múltiplos das economias mundiais atuais por átomo.132

Sendo claro, não é que teríamos amontoado várias economias mundiais atuais em cada átomo. É que teríamos amontoado algo 1071 vezes mais valioso que a economia mundial atual em meros 1028 átomos que compõem um ser humano.

O que significaria, porém, valorizar uma única experiência, 1071 vezes mais do que toda a economia mundial atual?

Uma maneira de pensar sobre isso pode ser:

- “Uma probabilidade de 1 em 1071 dessa coisa ser vivenciada ser tão valiosa

quanto toda a economia mundial atual.”

- Ou, para tornar isso um pouco mais fácil de intuir (embora precise simplificar demais), “Se eu fosse neutro em relação ao risco, ficaria emocionado em aceitar uma aposta em que morreria imediatamente, com quase certeza, em troca de 1 em 1071 chance de ter essa experiência.”133

- O quanto a morte seria quase certa? Bem, para começar, se todas as pessoas que já viveram até hoje aceitassem essa aposta, seria quase certo que todas perderiam e acabariam mortas imediatamente.143

- Isso realmente não chega nem perto de transmitir o quanto as chances de ganhar essa aposta seriam ruins. É mais como: se houvesse uma pessoa para cada átomo na galáxia, e cada um deles fizesse a aposta, provavelmente todos perderiam.135

- Então, para fazer uma aposta pessoal com esse tipo de probabilidade… é melhor que a experiência seja REALMENTE boa para compensar.

- Não estamos falando de uma experiência do nível “a melhor experiência que você já teve” aqui — não seria sensato valorizar isso mais do que uma vida inteira, e a ideia de que vale tanto quanto a economia mundial atual parece claramente errada.

- Estamos falando de algo insondavelmente além de qualquer coisa que qualquer ser humano já experimentou.

Aumentando os números mais ainda

Imagine o melhor segundo da sua vida, o tipo de coisa evocada por Letter from Utopia (Carta da Utopia):

Você já experimentou um momento de felicidade? Nas corredeiras da inspiração, talvez, sua mente traçando as formas da verdade e da beleza? Ou talvez no êxtase pulsante do amor? Ou em um triunfo glorioso alcançado com amigos verdadeiros? Ou em uma conversa em um terraço coberto de videiras em uma noite estrelada? Ou talvez uma melodia se tenha infiltrado em seu coração, encantando-o e incendiando-o com emoções caleidoscópicas? Ou quando você rezou e se sentiu ouvido?

Se você experimentou tal momento – experimentou o melhor tipo de tal momento – então você pode ter descoberto dentro dele um certo pensamento ocioso, mas sincero: “Oh céus, sim! Eu não sabia que poderia ser assim. Isso está tão certo, em um nível totalmente diferente de certo; tão real, em um nível totalmente diferente de real. Por que não pode ser assim sempre? Antes eu estava dormindo; agora estou acordado.”

No entanto, um pouco mais tarde, apenas uma hora se passou, e a fuligem em queda permanente da vida cotidiana já está cobrindo tudo. A prata e o ouro da exuberância perdem o brilho, e o mármore fica sujo.

Agora imagine, implausivelmente, que este único segundo valesse tanto quanto toda a produção da economia mundial atual em um ano. (Não parece possível que valesse mais, já que a economia mundial naquele ano incluía aquele segundo da sua vida, mais o resto do seu ano e os anos de muitas outras pessoas.)

E agora imagine um ano inteiro no qual cada segundo é tão bom quanto aquele segundo. Chamaremos isso de “ano perfeito”. Segundo as suposições acima, o ano perfeito não seria mais do que cerca de 3X108 vezes mais valioso que a economia mundial (existem cerca de 3X108 segundos em um ano).

E agora imagine que cada átomo da galáxia pode ser uma pessoa tendo o ano perfeito. Isso seria agora cerca de 1070 X (3 X 108) = 3X1078 tanto valor quanto a economia mundial atual. Um crescimento de 2% nos levaria até lá em 9150 anos.

(Uma suposição crucial e talvez contraintuitiva que estou fazendo aqui é que “2% de crescimento” significa “2% de crescimento verdadeiramente real” – que o que quer que seja valioso, falando de forma holística, sobre a produção mundial anual atual, ganharemos 2% a mais disso a cada ano. Acho que esse já é o tipo de suposição que muitas pessoas estão fazendo quando dizem que não precisamos de mais material para ter uma riqueza crescente. Se você acha que o crescimento de 2% do passado recente é mais “falso” do que isso e que continuará de forma “falsa”, isso seria um debate para outra hora). Esse parêntese desse parágrafo é mesmo necessário?

E 1200 anos depois disso, se cada ano ainda tivesse 2% de crescimento, a economia seria aproximadamente 20 bilhões de vezes maior. Então agora, para cada átomo na galáxia, deve haver alguém cujo ano seja, em certo sentido, 20 bilhões de vezes melhor. Ou “mais valioso” do que o ano perfeito.

Ainda estamos falando de aproximadamente 10.000 anos de crescimento de 2%.

Novas formas de vida

Isso ainda é concebível! Quem sabe o que o futuro trará?

Mas, neste ponto, é muito intuitivo para mim que não estamos falando sobre nada que se pareça com “Humanos em corpos humanos tendo tipos humanos de diversão e satisfação”. Uma economia desse valor parece exigir fundamentalmente a reengenharia de algo sobre a experiência humana – encontrar alguma maneira de organizar a matéria que crie muito mais felicidade, ou realização, ou algo que valorizaríamos tão astronomicamente mais do que até mesmo as alturas da experiência humana hoje.

E acredito que a maneira mais natural de isso acontecer seria algo como: “Descobrir princípios fundamentais por trás do que valorizamos e princípios fundamentais de como organizar a matéria para tirar o máximo dela.” O que, por sua vez, sugere algo mais como “Uma vez que tivéssemos esse nível de compreensão, começaríamos a organizar a matéria na galáxia de maneira otimizada e rapidamente nos aproximaríamos dos limites do que é possível” do que algo semelhante a “Cresceríamos 2%, todos os anos, por milhares de anos contínuos, mesmo quando (como aconteceria com, por exemplo, pessoas digitais) nos tornássemos seres que conseguissem fazer tanto em um ano quanto os humanos fizessem em centenas ou milhares de anos.”

Mas isso ainda pode acontecer?

Acho que sim? Isso nunca foi uma prova matemática da impossibilidade de crescimento de 2% ao ano. É possível em teoria.

Mas, neste ponto, vendo que galáxia excêntrica e fundamentalmente transformada seria necessária dentro de 10.000 anos, qual é a razão afirmativa para esperar um crescimento de 2% ao ano por um longo período? É que “Esta é a linha de tendência e, por padrão, espero que a linha de tendência continue?”

Mas essa linha de tendência tem apenas algumas centenas de anos — por que esperar que continue por mais 10.000?

Por que não, em vez disso, esperar que o padrão de longo prazo de aceleração do crescimento econômico continue, até que nos aproximemos de algum tipo de limite fundamental sobre quanto valor podemos atribuir a uma determinada quantidade de matéria? Ou, esperar que o crescimento diminua gradualmente a partir daqui e nunca mais atinja o nível de hoje?

Os últimos dois séculos foram uma grande aventura, com a riqueza e as condições de vida melhorando a uma taxa historicamente alta. Mas não acredito que isso nos dê motivos para pensar que essa tendência continuará até o infinito. Acredito que os limites estão em algum lugar, e parece que em algum momento nos próximos 10.000 anos, teremos que nos aproximar desses limites, ou estagnar, ou crescer, ou entrar em colapso.

Espero ter dado uma ideia do porquê parece tão improvável que haverá mais 10.000 anos no futuro, com 2% ou mais de crescimento a cada ano. O que sugere que cada um dos últimos 100 anos ou mais será um dos 10.000 anos de crescimento mais rápido de todos os tempos.

Se quiser comentar esta postagem, este seria um bom lugar para fazê-lo.

Uma nota sobre o crescimento econômico histórico

Como o argumento do “século mais importante” é afetado se nossa imagem da história

econômica de longo prazo mudar.

Algumas vezes na série o século mais importante (particularmente em O Duplicador), digo que o crescimento econômico nos últimos milhares de anos se ajusta razoavelmente ao padrão (descrito aqui) de crescimento acelerado, impulsionado por uma retroalimentação: “mais ideias → mais resultados → mais pessoas → mais ideias→ …”

Este argumento é o assunto de um debate em curso (veja esta postagem no Fórum do Altruísmo Eficaz feita por Ben Garfinkel, e as extensas trocas de mensagens nos comentários).

Meu melhor palpite é que os dados anteriores são, de fato, um ajuste razoável (embora ambíguo) ao padrão de crescimento acelerado. No entanto, estou longe de confiar nisso e quero abordar como isso afetaria meus argumentos se, dados futuros melhores acabassem por minar decisivamente esse ajuste.

Extrapolando o crescimento econômico futuro com base em (uma visão de longo prazo) do crescimento econômico passado

Citei a projeção, feita em Modeling the Human Trajectory (Modelando a trajetória humana), que a economia está “no caminho” de atingir tamanho infinito neste século se o padrão observado no passado continuar. Se os dados anteriores acabassem sendo inconsistentes com o crescimento acelerado, isso prejudicaria o Modeling the Human Trajectory (Modelando a trajetória humana), e uma nova extrapolação seria necessária. No entanto, meu melhor palpite é que uma boa extrapolação de substituição ainda mostraria uma boa chance de crescimento explosivo (até “infinito”) neste século. Segue o raciocínio para essa suposição.

Ao discutir o padrão de crescimento passado, a principal alternativa que vi para acelerar o crescimento (inclusive na postagem do Fórum EA vinculada acima e nos comentários) é uma série de “modos de crescimento” fundamentalmente diferentes, cada um com sua própria dinâmica de crescimento e/ou taxa de crescimento. Por exemplo, talvez — em vez de pensar na história econômica como uma aceleração gradual — pode-se pensar nela como faseada:

- Uma fase pré-agricultura (com início há alguns milhões de anos), na qual o crescimento provavelmente foi extremamente lento e talvez bastante caótico.

- Uma fase após o desenvolvimento da agricultura (com início há cerca de 10.000 anos), durante a qual o crescimento foi provavelmente mais rápido do que antes, mas ainda bastante lento para os padrões atuais e talvez bastante caótico também.

- A fase moderna pós-Revolução Industrial (começando há aproximadamente 200 anos), com, de longe, o crescimento mais rápido.

Parece indiscutível para mim que a terceira fase é muito mais curta (no tempo histórico) e tem um crescimento dramaticamente mais rápido, em comparação com as duas primeiras fases. Isso poderia ser o resultado de uma aceleração contínua ou o surgimento de um modo de crescimento fundamentalmente novo. Este último levantaria, então, a questão de saber se uma transição para outro “modo de crescimento” ainda mais rápido seria possível.

O artigo de 2000 de Robin Hanson, Long-Term Growth As A Sequence of Exponential Modes (Crescimento de Longo Prazo como uma Sequência de Modos Exponenciais), é a principal tentativa que conheço de explorar essa questão. Ele tenta modelar a história econômica de longo prazo usando algumas abordagens diferentes, ambas projetadas em torno da ideia de “modos de crescimento” e (nas páginas 14–17) para extrapolar os padrões observados até o momento no futuro. Ele afirma que:

Em resumo, se alguém levar a sério o modelo de crescimento econômico como uma série de modos de crescimento exponencial, e se os parâmetros de mudança relativa de uma nova transição provavelmente forem semelhantes aos parâmetros que descrevem as transições anteriores, seria difícil escapar da conclusão de que a economia mundial poderá passar por uma mudança muito dramática no próximo século, para um novo modo de crescimento econômico com um tempo de duplicação de aproximadamente duas semanas ou menos…

Se o próximo modo tivesse um tempo de duplicação “lento” de dois anos, e se durasse vinte vezes de duplicação, mais do que qualquer modo visto até agora, ainda assim ele duraria apenas quarenta anos. Depois disso, não está claro quantos modos de crescimento ainda mais rápidos são possíveis antes de atingir os limites fundamentais. Mas é difícil entender como tais limites fundamentais não seriam alcançados dentro de algumas décadas, no máximo.

Isso é qualitativamente muito semelhante à projeção que dei nas postagens do blog: ambos implicam uma aceleração econômica dramática no século XXI e ambos implicam “crescimento infinito” ou “atingir limites fundamentais” não muito tempo depois (embora o atraso potencial seja mais longo na abordagem de Hanson e poderia modestamente chegar até o século XXII, dependendo de qual projeção de Hanson se usa).

Essa extrapolação é menos direta do que a extrapolação feita em Modeling the Human Trajectory (Modelando a trajetória humana). Não há razões muito fortes para pensar que a série de modos de crescimento seguirá um padrão específico, em termos de como eles são cronometrados e que tipo de crescimento eles trarão. A extrapolação de Hanson é apenas uma estimativa sobre o que esperar se eles seguirem um padrão relativamente regular. Ainda assim, parece razoável para mim como uma melhor estimativa.

Outras implicações se os dados econômicos anteriores não se encaixarem em um padrão de “crescimento acelerado”

- Ao longo da série, defendo que várias tecnologias (O duplicador , pessoas digitais, o “PASTA”136) levariam a um padrão de “aceleração” que levaria a um crescimento explosivo. Esta é uma implicação da maioria dos modelos teóricos dominantes na economia do crescimento, conforme discutido em Report on Whether AI Could Drive Explosive Economic Growth (Relatório sobre se a Inteligência Artificial pode impulsionar o crescimento econômico explosivo).137 Cito que os dados anteriores parecem se encaixar nessa dinâmica como evidência adicional de que tal coisa é plausível. Se os dados anteriores não se ajustassem à dinâmica, isso não afetaria este caso teórico para a expectativa de um crescimento explosivo, mas tornaria a solidez geral do argumento um pouco mais fraca.

- Também argumentarei contra a ideia de que “se a Inteligência Artificial transformadora fosse desenvolvida neste século, isso quebraria o padrão de crescimento econômico constante que observamos; portanto, devemos ter um ônus de prova muito alto para previsões de Inteligência Artificial transformadora neste século”. Para esse propósito, a dinâmica de “crescimento acelerado” ou “série de diferentes modos de crescimento” parece suficiente para o meu caso de que devemos considerar plausível uma futura explosão de crescimento, embora eu ache que o caso seria um pouco mais fraco se tivesse que confiar neste último em oposição ao primeiro.

Conclusão

No geral, se ficar claro que a história econômica contém muito pouca aceleração (e, em vez disso, é mais bem pensada como uma série de “modos de crescimento” distintos), acredito que minhas afirmações e conclusões restantes ainda pareceriam corretas, embora os argumentos fossem um pouco mais fracos.

Também é possível que, se tivéssemos informações perfeitas sobre a história econômica de longo prazo, veríamos uma mistura: algumas instâncias/períodos da dinâmica de “crescimento acelerado” descrita aqui, alguns períodos que se parecem mais com “modos distintos de crescimento”.

Alguns detalhes adicionais sobre o que quero dizer com “século mais importante”

Aqui está um pouco mais de detalhes sobre o que quero dizer quando falo sobre o “século mais importante para a humanidade”.

Existem dois sentidos diferentes em que acredito que este pode ser o “século mais importante”, um deles de maior risco e menos provável do que o outro:

Significado nº 1: O século mais importante de todos os tempos para a humanidade, devido à transição para um estado no qual os humanos, tais como os conhecemos, não serão mais a força principal nos eventos mundiais.

Aqui, a ideia é que:

- Durante este século, a civilização poderia terminar completamente ou mudar tão dramaticamente que “os humanos tais como os conhecemos hoje” não existiriam mais ou seriam pelo menos uma parte muito pequena da população.

- Acho que o futuro que descrevo em Pessoas digitais seriam mais importantes ainda provavelmente atingiria esse nível de estranheza muito rapidamente.

- A possibilidade dos sistemas de Inteligência Artificial se expandirem pela galáxia com base em seus próprios objetivos – com os humanos se tornando bastante irrelevantes em comparação – também se qualificaria.

- Este século é a nossa chance de moldar como isso acontece.

- Se desenvolvermos pessoas digitais, o conjunto inicial de pessoas digitais poderia rapidamente começar a fazer muitas cópias de si mesmas, multiplicando-se e trabalhando a uma taxa muito mais rápida do que os humanos normais conseguiriam rastrear ou acompanhar. Considerando esses argumentos, o conjunto inicial de pessoas digitais — e as condições virtuais em que são colocadas — seriam cruciais de forma duradoura.

- Se, em vez disso, desenvolvêssemos sistemas de Inteligência Artificial que se expandiriam pela galáxia com base em seus próprios objetivos, isso faria com que perdêssemos permanentemente a oportunidade de fazer com que a força principal nos eventos mundiais seja algo parecido com os humanos.

Com base nesses argumentos, este seria o “século mais importante” para os humanos tais como somos agora, no sentido de que essa será a melhor oportunidade que os humanos terão de influenciar um grande futuro pós-humanos-tais-como-são-agora.138

Isso pode ser consistente com outros séculos sendo “mais importantes” para outras “espécies”.

- Algum século passado pode ter sido o século mais importante para os chimpanzés. (Isso pode ter ocorrido em algum século durante o qual os humanos começaram a surgir.)

- Algum século futuro pode ser o século mais importante para o que quer que “venha depois dos humanos”. (Embora este século seja o mais importante para eles também.)

Quero dizer, aproximadamente, que se algo como o PASTA for desenvolvido neste século, ele tem pelo menos 50/50 de probabilidade de ser o “século mais importante” no sentido dito acima.

Significado nº 2: o século mais importante de todos os tempos para toda a vida inteligente em nossa galáxia.

É possível, pelas razões descritas aqui, que independentemente da força principal nos eventos mundiais (talvez pessoas digitais, Inteligência Artificial desalinhada ou qualquer outra coisa), ela criará civilizações altamente estáveis com valores “aprisionados”, que povoarão toda a nossa galáxia por bilhões de anos por vir.

Se o suficiente desse “aprisionamento/lock-in” acontecer neste século, isso poderá torná-lo o século mais importante de todos os tempos para toda a vida inteligente em nossa galáxia.

Quero dizer, aproximadamente, que se algo como o PASTA for desenvolvido neste século, ele tem pelo menos 25% de chance de ser o “século mais importante” no sentido dito acima. Isso é metade da probabilidade da versão anterior do “século mais importante”. Não pretendo ser preciso aqui. Estou dando uma indicação aproximada de quão provável seria tal desenvolvimento.

Para se ter uma melhor ideia disso, vale notar que o mundo parece ter “acelerado” – no sentido de mudar mais rapidamente – ao longo da história, e poderia continuar assim se algo como o PASTA for desenvolvido. Considerando essas afirmações:

- Se as primeiras bactérias estivessem conversando entre si, uma delas poderia ter afirmado que elas estavam no “período mais importante de 5 bilhões de anos,” aquele no qual as bactérias evoluiriam para animais complexos.

- Os primeiros animais complexos poderiam ter afirmado estarem no “éon,” mais importante”(???), aquele no qual os humanos emergiriam.

- Alguém vivendo a Revolução Científica poderia afirmar que estava no “milênio mais importante”, aquele no qual o progresso científico e tecnológico decolaria.

- Se a Inteligência Artificial transformadora levar a uma civilização gerida por pessoas digitais por volta de, digamos, 2080, alguma pessoa digital em 2080 poderá alegar que está na “década mais importante”. Uma década pode parecer para eles o mesmo que um século (ou mais) se parece para nós.

- Essas pessoas digitais poderiam criar pessoas digitais mais avançadas que afirmariam estar no “dia mais importante”, imaginando que evoluirão para algo ainda mais estranho durante esse vasto intervalo de tempo.

- E todos eles poderiam estar certos!

Intenção holística da frase “século mais importante”. Em grande parte, escolhi a frase “século mais importante” como um chamado de atenção sobre o quão elevados são os riscos que podemos enfrentar.

Embora eu tenha tentado dar um significado um pouco mais preciso acima, minha principal intenção é chamar a atenção para o sentimento de perplexidade diante da possibilidade de desenvolver algo como o PASTA neste século, que por sua vez levaria a um futuro radicalmente desconhecido, possivelmente envolvendo uma civilização estável em toda a galáxia.

Se eu estiver certo sobre esse cenário, mas errado sobre o “século mais importante” por algum motivo (por exemplo, talvez algo ainda mais notável aconteça daqui a 5 bilhões de anos, ou talvez aconteça que a hipótese da simulação esteja correta), eu ainda acredito que a ideia geral desta série está correta.

Por que falar agora sobre daqui a 10.000 anos?

Parece que uma reação comum a Isto não pode continuar é algo como: “Ok, então você está dizendo que o atual nível de crescimento econômico não pode continuar por mais 10.000 anos… Então me ligue daqui a alguns milhares de anos, talvez.”

Em geral, este blog costuma falar sobre períodos “longos” (décadas, séculos, milênios) como se fossem “curtos” (em comparação com os bilhões de anos que nosso universo existe, milhões de anos que nossa espécie existe e bilhões de anos que poderiam estar no futuro de nossa civilização). Eu meio que tento me imaginar como um observador de bilhões de anos, olhando para gráficos como este e pensando coisas como “O atual nível de crescimento econômico acabou de começar!” mesmo que tenha começado várias vidas atrás.

Por que pensar desta forma?

Uma razão é que é apenas uma maneira de pensar sobre o mundo que parece (para mim) revigorante/diferente.

Mas aqui estão mais algumas razões importantes.

Altruísmo eficaz

Minha principal obsessão é com o altruísmo eficaz, ou fazer o máximo de bem possível. Geralmente tento prestar mais atenção às coisas quando elas “importam mais” e acredito que as coisas “importam mais” quando afetam um número maior de pessoas.139

Acho que haverá MUITO mais pessoas140 nos próximos bilhões de anos do que nas próximas gerações ou poucas. Portanto, acredito que o futuro de longo prazo, em certo sentido, “importa mais” do que o que quer que aconteça na próxima geração ou em algumas poucas gerações. Talvez não importe mais para mim e meus entes queridos, mas importa mais do ponto de vista de “todos os seres são igualmente importantes”.141

Uma resposta óbvia é “Mas não há nada que possamos fazer que afete TODAS as pessoas que viverão nos próximos bilhões de anos. Devemos nos concentrar no que realmente podemos mudar – isso é na próxima geração ou poucas mais adiante.”

Mas não estou convencido disso.

Acho que poderíamos estar no século mais importante de todos os tempos, e acredito que as coisas que fazemos hoje podem acabar importando por bilhões de anos (um exemplo óbvio é reduzir o risco de catástrofes existenciais).

E, de maneira mais ampla, se eu não conseguisse pensar em maneiras específicas pelas quais nossas ações poderiam ser importantes por bilhões de anos, ainda assim eu estaria muito interessado em descobrir essas maneiras. Eu ainda acharia útil tentar dar um passo para trás e perguntar: “O que estou lendo nas notícias é importante no final das contas? Esses eventos importariam se no futuro terminarmos com uma economia em explosão, estagnação ou colapso? Para que tipo de civilização digital serão nossas criações de longo prazo? E se não pudermos criar… o que poderia?”

Apreciando a estranheza do tempo em que vivemos

Acho que vivemos em uma época muito estranha. Ela parece muito estranha em vários gráficos (como este, este, e este). A maioria do avanço científico e tecnológico e do crescimento da economia aconteceu em uma pequena fração de tempo em que estamos vivendo. E daqui a bilhões de anos, provavelmente ainda será o caso de que esta pequena fração de tempo seja um ponto fora da curva em termos de crescimento e mudança.

Mais uma vez, não parece uma pequena fração de tempo, parece uma vida inteira São centenas de anos. Mas isso é dentre milhões (para nossa espécie) ou bilhões (para a vida na Terra).

Às vezes, quando ando na rua, olho em volta e penso: “Isso tudo é TÃO ESTRANHO. Ao meu redor, um grupo de pessoas dirige carros de aço a mais de 60 km/h, com tranquilidade. Vejo também um guindaste gigante a construir um arranha-céu, operado calmamente por um grupo de pessoas. No céu, um avião voa. Após bilhões de anos de vida na Terra, somos nós — os humanos dos últimos cem ou mais anos — os únicos capazes de realizar tais feitos. Praticamente tudo o que vejo é uma tecnologia futurista maluca que acabamos de inventar e para a qual não tivemos tempo de nos adaptar, e não teremos nos adaptado antes que a próxima coisa maluca apareça.

“E todo mundo está sendo muito monótono em seus carros, arranha-céus e aviões, mas isso não é normal, isso não é como geralmente é,’ isso não faz parte de um plano ou um padrão bem estabelecido, isso é louco, estranho e de curta duração, e ninguém sabe para onde isso vai a seguir.”

Acho que muitos de nós somos instintiva e intuitivamente desdenhosos de afirmações audaciosas sobre o futuro. Acho que naturalmente imaginamos que exista mais estabilidade, solidez e sabedoria oculta em “como as coisas têm sido por gerações” do que realmente existe.

Ao tentar imaginar a perspectiva de alguém que esteve vivo durante toda a história — bilhões de anos, não dezenas — talvez possamos estar mais abertos a estranhas possibilidades futuras. E então, talvez possamos perceber melhor as que realmente podem acontecer e que podem ser afetadas pelas nossas ações de hoje.

É por isso que costumo tentar dizer coisas como “X já está acontecendo há 200 anos e talvez possa durar mais alguns milhares de anos — ah, isso é um piscar de olhos!”

Notas de fim

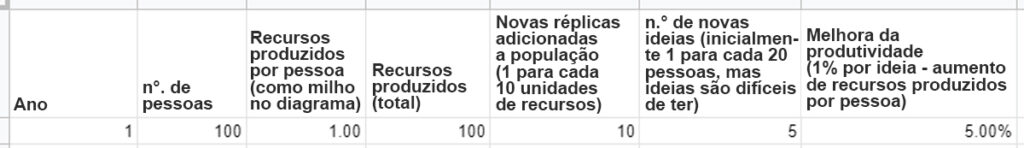

1 Começaremos com a economia:

100 pessoas produzem 100 unidades de recursos (1 por pessoa). Para cada 10 unidades de recursos, elas podem criar mais 1 duplicata (isso é apenas para capturar a ideia de que duplicatas são “caras” de criar). E essas 100 pessoas têm 5 novas ideias, levando a um crescimento de produtividade de 5%.

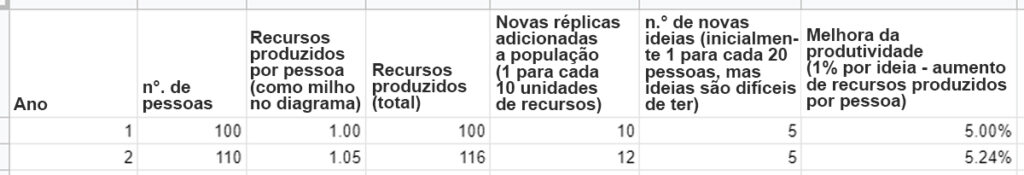

Aqui está o ano 2:

Agora cada pessoa produz 1,05 widgets em vez de 1, graças ao crescimento da produtividade. E a produtividade cresce mais 5%.

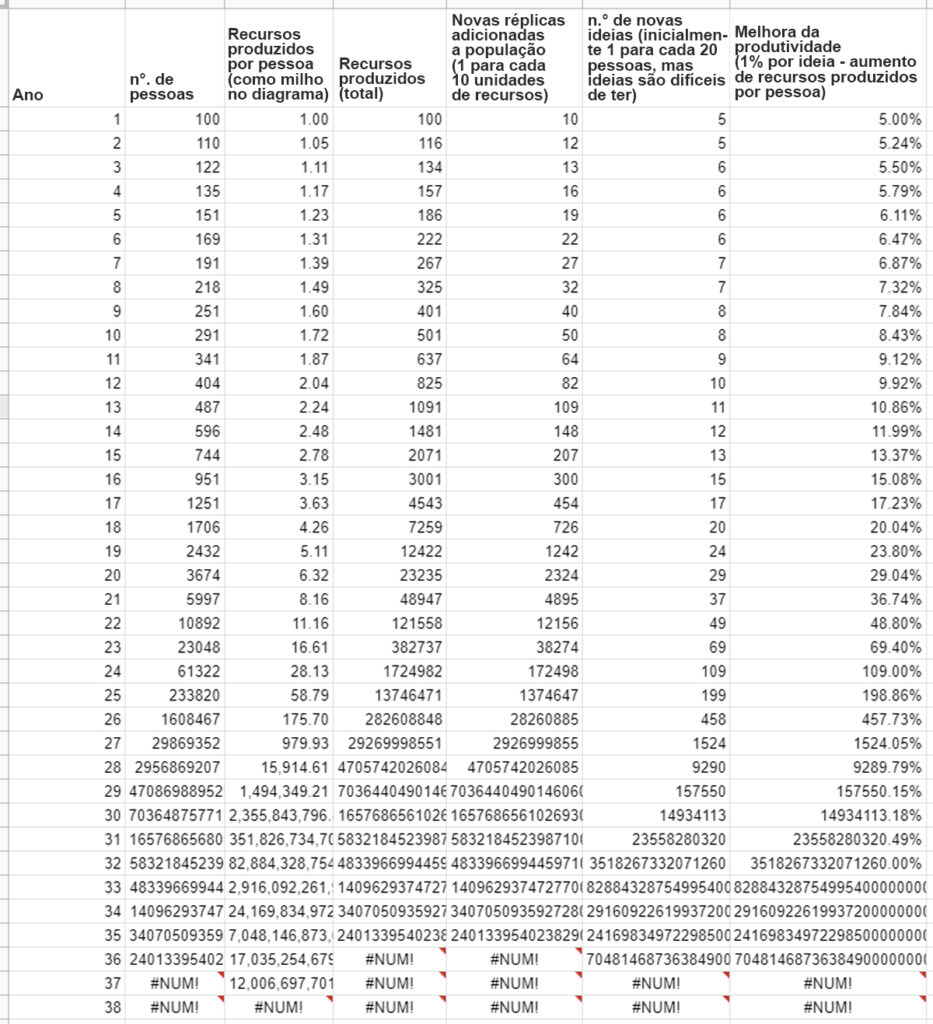

Essa dinâmica leva algum tempo para “decolar”, mas decola:

Os #NUM! na parte inferior significam que o Google Planilhas engasga com os números grandes.

Minha planilha inclui uma versão com população simplesmente crescente exponencialmente; esse aqui continua por aproximadamente 1000 anos sem desafiar o Google Planilhas. Portanto, a dinâmica populacional é fundamental aqui.

Sem corpos humanos – e dependendo de quais tipos de robôs estiverem disponíveis

- as pessoas digitais poderiam não ser bons substitutos para os humanos quando se trata de trabalhos que dependem fortemente de habilidades físicas humanas ou trabalhos que exigem interação pessoal com humanos biológicos.

No entanto, as pessoas digitais provavelmente conseguiriam fazer tudo o que fosse necessário para causar um crescimento econômico explosivo, mesmo que não conseguissem fazer tudo. Em particular, parece que elas conseguiriam fazer tudo o que fosse necessário para aumentar a oferta de computadores e, assim, aumentar a população de pessoas digitais.

Criar mais poder computacional requer (a) matérias-primas – principalmente metal;

- pesquisa e desenvolvimento – para projetar os computadores; (c) manufatura – executar o projeto e transformar matérias-primas em computadores; (e) energia. Pessoas digitais tornariam todas essas coisas muito mais baratas e abundantes:

- Matérias-primas. A mineração poderia, em princípio, ser feita inteiramente com robôs. Pessoas digitais projetariam e instruiriam esses robôs para extrair matérias-primas da maneira mais eficiente possível.

- Pesquisa e desenvolvimento. Minha impressão é que este é um fator importante no custo da computação hoje: o trabalho necessário para projetar microprocessadores cada vez melhores e outras peças de computador. Pessoas digitais fariam isso totalmente virtualmente.

- Manufatura. Minha impressão é que esta é outro fator importante no custo da computação hoje. Como a mineração, isso poderia, em princípio, ser feito inteiramente com robôs.

- Energia. Os painéis solares também estão sujeitos a (a) melhor pesquisa e desenvolvimento; (b) manufatura acionada por robôs. Um bom design e fabricação de painéis solares acarretariam uma energia radicalmente mais barata e abundante.

Exploração espacial. Matérias-primas, energia e “locais para habitar” são superabundantes fora da Terra. Se as pessoas digitais projetassem e fabricassem naves espaciais, juntamente com robôs que construíssem painéis solares e fábricas de computadores, elas poderiam tirar proveito de recursos massivos em comparação com o que temos na Terra.

Notas

130A economia de hoje vale um pouco menos de US$ 1014 por ano (fonte). $1085 = $1014 x 1071.

131(E pagando o preço total por isso, de uma forma que fica registrada pelas estatísticas do PIB, que podem ficar um pouco complicadas.)

132Veja uma estimativa anterior de 1070 átomos na galáxia.